大規模言語モデル(LLM)とは?仕組みから活用事例まで完全解説

この記事は、大規模言語モデル(LLM)の基本から応用までを体系的に解説したものです。LLMの仕組み(Transformerや自己注意機構)、代表的モデル(GPT、BERT、LLaMA、日本語特化型モデル)、実用事例、導入時の課題・リスク、選定や統合の方法、将来展望などを網羅しています。特にビジネスでの活用と企業導入の実践的ガイドラインに重点を置き、効率化や生産性向上の可能性を具体的に示しています。

近年、ビジネス界で急速に注目を集めている大規模言語モデル(LLM)は、私たちの働き方や業務プロセスを根本的に変革する可能性を秘めています。ChatGPTの登場により一般にも身近になったLLMですが、その技術的な仕組みや実際のビジネス活用方法について、正確に理解している方は少ないのが現状です。本記事では、LLMの基本概念から最新の技術動向、具体的な活用事例、そして企業導入時の実践的なガイドラインまで、初心者の方にもわかりやすく包括的に解説します。

大規模言語モデル(LLM)とは何か

大規模言語モデルの定義と基本概念

大規模言語モデル(LLM:Large Language Models)とは、膨大なテキストデータと高度なディープラーニング技術を組み合わせて構築された、自然言語処理に特化したAIモデルです。人間が日常的に使用する言葉や文章のパターンを学習し、文脈を理解した上で自然な文章生成や質問応答を行うことができます。LLMは単純な単語の出現確率だけでなく、文章全体の意味や前後の関係性を深く理解することで、まるで人間が書いたような自然で一貫性のあるテキストを生成することが可能です。

従来の言語モデルとの根本的違い

従来の言語モデルが限られたデータセットと比較的単純なアルゴリズムに依存していたのに対し、大規模言語モデルは三つの要素において革命的な進歩を遂げています。まず「データ量」では、インターネット上の書籍、記事、ウェブページなど数兆語規模のテキストを学習データとして活用します。次に「計算量」では、従来モデルの数千倍から数万倍の処理能力を必要とする複雑な計算を実行します。そして「パラメータ数」では、従来の数百万個から数千億個へと飛躍的に増加し、より精密で柔軟な言語理解を実現しています。これらの要素が組み合わさることで、従来では不可能だった高度な文脈理解と自然な文章生成が可能になりました。

LLMが現代ビジネスで注目される理由

現代ビジネスにおいてLLMが注目される最大の理由は、業務効率化と生産性向上の劇的な可能性にあります。従来は人間が数時間から数日を要していた文書作成、データ分析、カスタマーサポート、翻訳作業などを、LLMは数分から数秒で高品質に処理できます。特に労働力不足や人件費上昇に悩む企業にとって、24時間365日稼働可能なLLMは強力なソリューションとなります。また、創造性を要する分野でも、アイデアの発想支援やコンテンツの原案作成など、人間の創造プロセスを補完する役割を果たし、従来の業務の枠組みを超えた新しい価値創造を可能にしています。

技術的特徴(データ量・計算量・パラメータ数)

LLMの技術的優位性は、三つの核心要素の飛躍的拡大によって実現されています。データ量においては、GPT-4クラスのモデルで約13兆語のテキストデータを学習に使用し、これは図書館数千館分の書籍に相当する膨大な知識を内包しています。計算量では、最新のLLMは数百万時間のGPU処理時間を要し、これは従来モデルの数万倍の計算リソースを消費します。パラメータ数については、最先端モデルでは1兆個を超えるパラメータを持ち、これにより極めて細かい言語ニュアンスや複雑な論理関係を捉えることが可能です。これらの技術的要素が相乗効果を生み出すことで、人間レベルに近い言語理解と生成能力を実現し、実用的なビジネスツールとしての地位を確立しています。

大規模言語モデルの技術的仕組み

Transformerアーキテクチャの革新性

Transformerアーキテクチャは、2017年にGoogleの研究者らが発表した「Attention Is All You Need」論文で提唱された革命的な技術基盤です。従来のRNNやLSTMといった順次処理モデルとは根本的に異なり、文章全体を並列処理することで高速かつ高精度な言語理解を実現しました。Transformerの核心である自己注意機構(Self-Attention)は、文章内の各単語が他のすべての単語とどの程度関連しているかを同時に計算し、文脈の複雑な依存関係を捉えることができます。この技術革新により、従来では処理困難だった長文の文脈維持や、離れた位置にある単語間の意味的関係の理解が可能になり、現在のLLMの基礎技術として広く採用されています。

トークン化からテキスト生成までの処理フロー

LLMの言語処理は、入力されたテキストを機械が理解できる形式に変換することから始まります。まずトークン化の段階で、入力文章を単語、句読点、記号などの最小意味単位に分割し、それぞれに数値IDを割り当てます。続くベクトル化の過程では、各トークンを高次元の数値ベクトルに変換し、単語間の意味的類似性や関係性を数学的に表現可能な形式にします。ニューラルネットワークによる学習段階では、複数の層を通じてデータを変換・調整し、入力データの特徴抽出と文脈理解を深化させます。最終的なデコード段階では、処理された情報を基に次に来る最適な単語を確率的に予測し、人間が理解できる自然なテキストとして出力します。この一連の処理が瞬時に実行されることで、リアルタイムでの高品質な文章生成が実現されています。

ニューラルネットワークによる深層学習プロセス

LLMの核心技術であるニューラルネットワークは、人間の脳神経回路を模倣した多層構造のコンピュータモデルです。最新のLLMでは数十から数百の層で構成された深層ネットワークを使用し、各層で異なるレベルの言語的特徴を学習します。初期層では文字や単語レベルの基本的パターンを認識し、中間層では文法構造や意味的関係を理解し、最終層では高度な推論や創造的思考に相当する処理を行います。学習プロセスでは、大量のテキストデータを繰り返し処理することで、数兆個のパラメータを最適化し、人間の言語使用パターンを内部表現として獲得します。この深層学習により、単純な統計的パターンマッチングを超えた、真の意味での言語理解と生成能力を実現しています。

自己注意機構(Self-Attention)による文脈理解

自己注意機構は、LLMが複雑な文脈関係を理解するための最重要技術であり、文章内の各単語が他のすべての単語とどの程度関連しているかを動的に計算します。例えば「私は川を渡るために橋を渡った」という文において、「橋」という単語が「川」や「渡る」という単語と強い関連性を持つことを自動的に識別し、「箸」ではなく建造物の「橋」であることを正確に理解します。この機構により、代名詞の参照先の特定、同音異義語の文脈に応じた使い分け、長距離依存関係の解析など、人間レベルの言語理解が可能になります。Multi-Head Attentionと呼ばれる発展形では、複数の注意パターンを並列処理することで、より多角的で精密な文脈分析を実現し、LLMの高度な言語能力の基盤となっています。

LLMと関連AI技術との違いと位置づけ

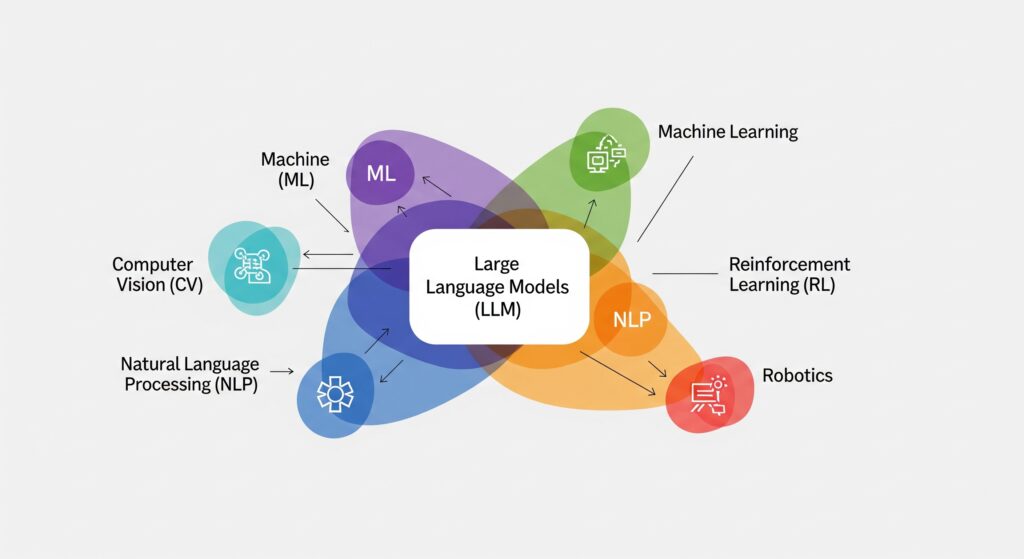

生成AIエコシステム内でのLLMの役割

生成AI(Generative AI)は、テキスト、画像、音声、動画などの多様なコンテンツを自動生成できるAI技術の総称であり、LLMはその中でテキスト生成に特化した中核的な技術分野です。生成AIエコシステム全体では、画像生成のDALL-E、動画生成のSora、音楽生成のMuseNetなど様々な専門分野が存在しますが、LLMは自然言語処理という最も汎用性の高い分野を担当しています。LLMの強みは、人間の主要なコミュニケーション手段である言語を扱うため、ビジネス文書作成、カスタマーサポート、教育、翻訳など幅広い業務に直接適用できることです。また、近年のマルチモーダル技術の発展により、LLMは他の生成AI技術と連携し、より統合的なAIソリューションの中核として機能するようになっています。

ChatGPTなど対話型AIサービスとの関係性

ChatGPTとLLMの関係は、製品とその基盤技術の関係として理解することができます。LLMは技術的な基盤であり、ChatGPTはその技術を活用して開発された具体的なサービス製品です。OpenAIのGPTシリーズ(GPT-3.5、GPT-4など)というLLMを基盤として、対話に特化したファインチューニングとユーザーインターフェースを加えたものがChatGPTです。同様に、Google BardはLaMDAやPaLMというLLMを基盤とし、Claude AIはAnthropic社独自のLLMを活用しています。これらの対話型AIサービスは、基盤となるLLMの能力に加えて、会話の流れを管理する機能、安全性フィルター、ユーザビリティ向上のためのインターフェース設計などが追加されており、一般ユーザーが簡単にLLMの能力を活用できるように最適化されています。

従来の機械学習・統計的言語モデルとの差異

従来の機械学習アプローチとLLMには、学習方法、処理能力、適用範囲において根本的な違いがあります。従来の統計的言語モデルは、特定のタスクに対して人間が手動でラベル付けしたデータセットを使用する教師あり学習が主流でした。一方、LLMは大量の未加工テキストデータから自己教師あり学習により言語パターンを習得し、特定タスクに限定されない汎用的な言語能力を獲得します。処理能力の面では、従来モデルが数万から数百万パラメータで構成されていたのに対し、LLMは数億から数兆パラメータを持ち、はるかに複雑で微細な言語ニュアンスを捉えることができます。適用範囲においても、従来モデルが翻訳、分類、要約など単一タスクに特化していたのに対し、LLMは一つのモデルで多様なタスクを処理できる汎用性を実現しています。

マルチモーダルAIとの技術的比較

マルチモーダルAIは、テキスト、画像、音声、動画などの複数の情報形式を統合的に処理できるAI技術であり、LLMの発展形として注目されています。従来のLLMがテキストのみを扱っていたのに対し、GPT-4のようなマルチモーダル対応LLMは、画像を含む入力を受け取ってテキストで応答することが可能です。技術的には、異なる形式のデータを統一的なベクトル空間にエンコードする技術や、複数のモダリティ間の相互作用を学習するクロスアテンション機構が重要な役割を果たします。ビジネス応用の観点では、マルチモーダルAIは文書の画像からテキスト抽出と要約の同時実行、商品画像の分析と説明文生成、医療画像の解析と診断支援など、より複雑で高度なタスクを処理できます。ただし、処理の複雑性と計算コストが大幅に増加するため、用途に応じてテキスト特化型LLMとマルチモーダルAIを使い分けることが重要です。

主要な大規模言語モデルの種類と進化

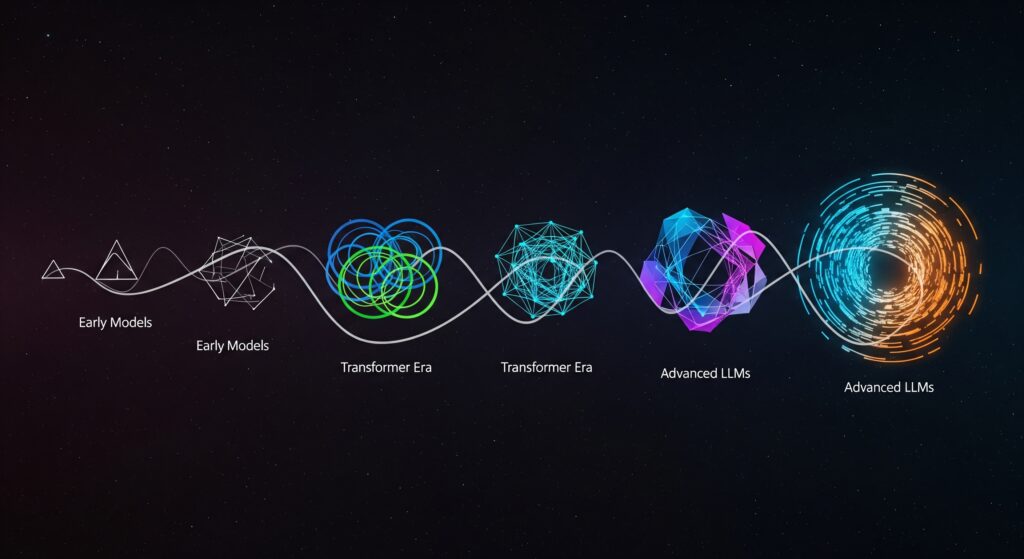

OpenAI GPTシリーズ(GPT-3/4/o3-mini)の特徴

OpenAI GPTシリーズは、現在最も広く知られているLLMファミリーであり、GPT-3からGPT-4、そして最新のo3-miniまで継続的な進化を遂げています。GPT-3は2020年の発表時に1750億パラメータという圧倒的な規模で業界に衝撃を与え、自然な文章生成能力の高さから商用化の道筋を切り開きました。GPT-4では、テキスト処理能力の向上に加えて画像入力にも対応したマルチモーダル機能を実装し、より複雑なタスクの処理が可能になりました。2024年12月に発表されたo3-miniは、推論能力を大幅に強化した革新的なモデルであり、複雑な論理的思考や数学的問題解決において人間レベルの性能を実現しています。GPTシリーズの特徴は、事前学習による汎用性の高さと、ファインチューニングによる特定用途への適応性の両立にあり、API提供により幅広い開発者が活用できる点も大きな優位性となっています。

Google開発モデル(BERT・LaMDA・PaLM)

Google社は独自のアプローチでLLM開発を進めており、BERTからLaMDA、PaLMまで多様なモデルを展開しています。2018年に発表されたBERT(Bidirectional Encoder Representations from Transformers)は、文章を双方向から読み取る革新的な仕組みにより、文脈理解能力を飛躍的に向上させ、質問応答や文書分類などのタスクで当時の最高性能を達成しました。LaMDA(Language Model for Dialogue Applications)は対話に特化した設計により、より自然で一貫性のある会話能力を実現し、Google Bardの基盤技術として活用されています。PaLM(Pathways Language Model)は5400億パラメータという大規模構成により、複雑な推論タスクや多言語処理において優れた性能を発揮します。Googleモデルの特徴は、検索エンジンで培った膨大なデータ処理技術と、最新情報へのリアルタイムアクセス能力を活かした実用性の高さにあります。

Meta LLaMAとオープンソース動向

Meta社のLLaMA(Large Language Model Meta AI)シリーズは、オープンソース戦略により業界に大きな影響を与えているLLMファミリーです。LLaMA 1では70億から650億パラメータまでの複数サイズのモデルを提供し、研究コミュニティに無償で公開することで、LLM研究の民主化を推進しました。LLaMA 2では商用利用も可能とし、企業が独自のAIソリューション開発に活用できる環境を整備しています。オープンソース戦略の利点は、透明性の高い開発プロセス、コミュニティによる継続的改善、導入コストの低減、カスタマイズの自由度などが挙げられます。この影響により、Alpaca、Vicuna、WizardLMなど多数の派生モデルが開発され、LLM技術の急速な普及と進歩が加速しています。企業にとっては、プロプライエタリモデルの代替選択肢として、セキュリティ要件の厳しい環境や特殊な業務要件に対応したソリューション構築が可能になっています。

日本語特化型LLM(NEC cotomiなど)の優位性

日本語特化型LLMは、日本語の言語的特性と日本のビジネス環境に最適化された重要な技術領域です。NEC社が開発したcotomiシリーズは、日本語の複雑な文法構造、敬語システム、文脈依存性の高い表現などを深く理解できるよう設計されており、日本語での質問応答や文書読解において世界トップレベルの性能を実現しています。cotomi Proとcotomi Lightという異なる性能レベルのモデルを提供することで、用途に応じた最適な選択が可能です。日本語特化型LLMの優位性は、日本語固有の言語現象への対応精度の高さ、日本の法制度や商慣習を反映した回答生成、個人情報保護などのセキュリティ要件への配慮、オンプレミス環境での運用可能性などにあります。特に金融機関や政府機関など機密性の高い業務では、データの国外流出リスクを回避しながら高品質な言語処理を実現できる日本語特化型LLMの価値は極めて高いものとなっています。

大規模言語モデルの実用的活用事例

カスタマーサポート・チャットボット革新

LLM搭載チャットボットは、従来の定型応答型システムを大幅に進化させ、人間に近い自然な対話によるカスタマーサポートを実現しています。従来のチャットボットが予め設定されたシナリオに基づく限定的な応答しかできなかったのに対し、LLM搭載システムは顧客の複雑で多様な質問に対して文脈を理解した適切な回答を生成できます。ECサイトでは商品に関する詳細な質問への回答、金融機関では各種手続きの案内、SaaS企業では技術的なトラブルシューティング支援など、業界を問わず導入が進んでいます。24時間365日対応による顧客満足度向上、人的リソースの高付加価値業務への集中、一定品質でのサポート提供などの効果により、導入企業では平均30-50%の問い合わせ対応効率向上と人件費削減を実現しています。ファインチューニングにより企業固有の商品情報や業務知識を学習させることで、より専門性の高いサポートも提供可能です。

コンテンツ制作・マーケティング業務効率化

デジタルマーケティング分野におけるLLM活用は、コンテンツ制作プロセスの根本的変革をもたらしています。広告コピーライティングでは、商品特徴やターゲット顧客情報を入力することで、複数の広告文案を瞬時に生成し、A/Bテスト用の多様なバリエーション作成が可能になりました。SEO記事作成では、キーワードやトピックを指定することで構成案から本文まで一貫した記事の下書きを作成し、人間のライターが最終的な編集と品質向上に集中できる環境を構築しています。SNSマーケティングでは、ブランドトーンに合わせた投稿文の自動生成、フォロワーコメントへの適切な返信案作成、インフルエンサー向けコラボレーション提案文の作成などに活用されています。導入企業では従来の制作時間を60-80%短縮しながら、コンテンツ制作量を3-5倍に増加させることに成功しており、デジタルマーケティングの競争優位性確保に大きく貢献しています。

プログラミング支援・コード生成ツール

ソフトウェア開発領域におけるLLM活用は、GitHub Copilot、Amazon CodeWhisperer、Google Bardなどの実用ツールとして急速に普及しています。これらのツールは、開発者の意図を自然言語で記述するだけで、適切なプログラムコードを自動生成し、開発効率を大幅に向上させています。基本的な関数作成から複雑なアルゴリズム実装まで幅広く対応し、Python、JavaScript、Java、C++など主要なプログラミング言語での開発をサポートします。コード生成だけでなく、既存コードのバグ検出、リファクタリング提案、セキュリティ脆弱性の特定、API使用方法の説明、技術文書の自動生成など、開発ライフサイクル全体にわたる支援を提供します。導入企業では、新人プログラマーの学習期間短縮、経験豊富な開発者の生産性向上、コード品質の標準化などの効果が報告されており、平均的に開発速度が30-40%向上しています。

教育・学習支援プラットフォーム

教育分野でのLLM活用は、個別最適化された学習体験の提供により教育効果の向上を実現しています。オンライン学習プラットフォームでは、学習者の理解度や学習ペースに応じて、最適な説明方法や例題を自動生成し、個人に合わせた学習コンテンツを提供します。語学学習では、ネイティブレベルの会話練習相手として機能し、文法の間違いを指摘しながら自然な表現方法を教授します。プログラミング教育では、エラーの原因説明、コード改善提案、課題解決のヒント提供など、個別指導講師のような役割を果たします。企業研修では、業務マニュアルの質問応答、ケーススタディの分析、スキルテストの自動採点などに活用され、研修効果の測定と改善も可能です。学習者の質問に24時間対応できることで、従来の集合研修や固定スケジュール学習の制約を解消し、より柔軟で効果的な学習環境の構築を実現しています。

業界別活用成功事例

各業界の特性に応じたLLM活用により、業務効率化と新たな価値創造が実現されています。金融業界では、投資レポートの要約、リスク分析文書の作成、顧客向け金融商品説明資料の自動生成、コンプライアンスチェック支援などに活用され、規制の厳しい環境での業務効率化を実現しています。医療分野では、診療記録の要約、医学論文の検索・要約、患者向け説明資料の作成、医療従事者間の情報共有支援などで導入が進んでいます。製造業では、技術仕様書の作成、品質管理報告書の生成、設備保守マニュアルの更新、サプライチェーン管理での情報分析などに活用されています。法務分野では、契約書のドラフト作成、法的文書の要約、判例検索、コンプライアンス確認支援などで高い効果を発揮しています。小売業界では、商品説明文の作成、在庫管理レポート、顧客分析資料の生成、販売戦略立案支援などに利用され、業界全体のデジタル変革を加速させています。

LLM導入時の課題とリスク管理戦略

ハルシネーション(幻覚)問題と対策手法

ハルシネーションは、LLMが事実と異なる情報や存在しない内容を、あたかも真実であるかのように生成してしまう現象です。この問題は「Intrinsic Hallucinations」(学習データとは異なる事実を出力)と「Extrinsic Hallucinations」(学習データに存在しない情報を創造)の2つに分類されます。主な原因は、学習データの偏りや古い情報、モデルの確率的生成プロセス、不完全な知識の補完などが挙げられます。対策手法として、プロンプトエンジニアリングによる出力制御、外部知識ベースとの照合システム、ファクトチェック機能の統合、複数モデルの回答比較検証などが有効です。企業導入時には、重要な意思決定に関わる情報については必ず人間による最終確認を実施し、LLMの回答に対する批判的思考を維持することが重要です。また、定期的な出力品質監査と改善プロセスの構築により、ハルシネーションリスクを最小化できます。

プロンプトインジェクション攻撃の防止策

プロンプトインジェクション攻撃は、悪意のあるユーザーが巧妙に設計した入力により、LLMに意図しない動作や機密情報の開示をさせる新しいタイプのサイバー攻撃です。攻撃手法には、システムプロンプトの上書き、ロールプレイによる制限回避、間接的な指示による迂回などがあります。防止策として、入力プロンプトの事前フィルタリング、出力内容の後処理検証、システムプロンプトの堅牢化、ユーザー権限の階層化管理などが重要です。技術的対策では、プロンプト分離技術、コンテンツフィルタリングAIの併用、異常検知システムの導入、ログ監視による攻撃パターンの特定などが効果的です。組織的対策として、従業員へのセキュリティ教育、インシデント対応プロセスの整備、定期的なセキュリティ監査の実施、サードパーティサービス利用時の契約条件確認などを実施することで、総合的なセキュリティ体制を構築できます。

著作権・知的財産権侵害回避の指針

LLM利用時の著作権・知的財産権問題は、学習データに含まれる著作物の影響と、生成コンテンツの権利帰属という2つの側面から検討する必要があります。学習データ問題では、LLMが著作権保護下にある文書から学習した知識を基に類似コンテンツを生成する可能性があり、間接的な著作権侵害のリスクが存在します。生成コンテンツの権利については、LLMが生成した文章、コード、アイデアの所有権や利用権限が不明確な場合があります。回避策として、プロンプト設計時に特定の作品タイトルや作家名の使用を避ける、生成コンテンツの独自性検証ツールの活用、法務部門との事前相談体制の構築、利用規約とライセンス条項の詳細確認などが重要です。企業利用では、生成コンテンツの商用利用前の権利確認、オリジナリティチェックの実施、必要に応じた法的リスク評価、保険適用範囲の確認などにより、知的財産権リスクを最小化できます。

AI規制・コンプライアンス対応の実務

AI技術の普及に伴い、世界各国でAI規制法制の整備が進んでおり、企業はコンプライアンス対応の重要性が高まっています。EU AI法では、AI システムをリスクレベルに応じて分類し、高リスク用途での厳格な要件を定めています。米国では連邦政府レベルでのAI規制検討が進み、日本でもAI ガバナンスガイドラインが策定されています。企業が対応すべき主要項目には、AI システムの透明性確保、バイアス・差別防止対策、データプライバシー保護、アルゴリズムの説明可能性、監査・検証体制の構築などがあります。実務対応として、AI利用ポリシーの策定、リスクアセスメント手順の確立、従業員教育プログラムの実施、定期的なコンプライアンス監査、規制動向の継続的モニタリングなどが必要です。特に個人情報を扱う業務でのLLM利用では、GDPR、個人情報保護法、業界固有の規制要件への適合性を事前に確認し、適切なデータガバナンス体制を構築することが不可欠です。

企業におけるLLM導入の実践的ガイドライン

LLM選定のための定量的比較指標

LLM選定では、技術性能、コスト効率、セキュリティ要件、導入容易性の4つの軸で総合評価することが重要です。技術性能では、精度指標(BLEU、ROUGE スコア)、応答速度(レスポンスタイム)、処理可能な文字数制限、多言語対応能力を定量的に比較します。コスト効率では、初期導入費用、月額利用料金、API呼び出し単価、インフラ運用コスト、人件費削減効果を総合的に評価します。セキュリティ要件では、データ暗号化レベル、アクセス制御機能、監査ログ機能、コンプライアンス認証取得状況を確認します。導入容易性では、既存システムとのAPI互換性、技術サポート体制、ドキュメント整備状況、導入事例の豊富さを評価項目とします。評価手法として、PoC(概念実証)による実際の業務データでの性能テスト、TCO(総所有コスト)分析による5年間の投資対効果算出、リスクマトリックスによる潜在的課題の可視化などを実施し、客観的な選定根拠を確立します。

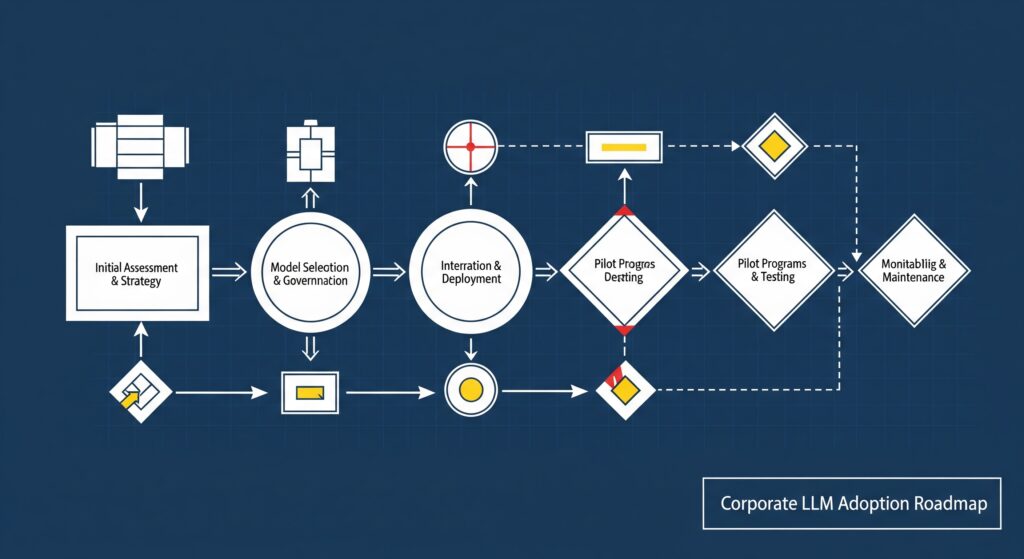

中小企業向け段階的導入ロードマップ

中小企業でのLLM導入は、限られたリソースと予算の制約下で最大効果を得るため、段階的アプローチが効果的です。第1段階(1-3ヶ月)では、既存のクラウドサービス(ChatGPT Plus、Google Bardなど)を活用した業務効率化の実証実験を行います。対象業務は文書作成、メール対応、議事録作成など、リスクが低く効果が見えやすい領域から開始します。第2段階(3-6ヶ月)では、API統合による業務システムとの連携を実施し、顧客対応チャットボットや社内FAQ システムの構築を行います。第3段階(6-12ヶ月)では、業務プロセス全体の最適化を図り、受注処理、在庫管理、マーケティング活動などの高度な自動化を実現します。各段階で投資対効果の測定と次段階への判断を行い、無理のない範囲で拡張していきます。中小企業の特徴である迅速な意思決定を活かし、大企業よりも速いペースでのデジタル変革実現が可能です。

既存システムとのAPI統合手法

LLMと既存システムの統合は、企業の投資保護と段階的なデジタル変革を実現する重要なアプローチです。統合アーキテクチャでは、APIゲートウェイを中心としたマイクロサービス設計により、LLM機能を既存システムに安全に組み込みます。データ連携では、CRM、ERP、MAツールなどの既存データベースとLLMの間でリアルタイムまたはバッチ処理による情報同期を実現します。認証・認可機能では、既存のID管理システム(Active Directory、LDAP)との連携により、セキュアなアクセス制御を維持します。ワークフロー統合では、既存の業務承認プロセスにLLMの提案機能を組み込み、人間による最終判断を保持した半自動化システムを構築します。技術的実装では、REST API、GraphQL、WebSocket等の標準プロトコルを使用し、既存システムへの影響を最小化します。運用面では、モニタリングツールによる統合システム全体の健全性監視、ログ管理による問題の早期発見、定期的な性能チューニングにより、安定した統合環境を維持します。

ROI測定と効果測定のKPI設計

LLM導入の投資対効果測定には、定量的指標と定性的指標を組み合わせた包括的なKPI設計が必要です。コスト削減効果では、業務処理時間の短縮率、人件費削減額、外注費用の削減額、システム運用コストの変化を測定します。生産性向上では、処理件数の増加率、品質指標の改善、顧客満足度スコア、従業員満足度の変化を評価します。新規事業創出では、LLM活用による新サービスの売上貢献、市場投入時間の短縮、イノベーション創出件数を指標とします。測定手法として、導入前後の比較分析、同業他社とのベンチマーク比較、顧客・従業員アンケート、財務指標への影響分析を実施します。ROI計算では、初期投資額、運用コスト、効果額を3-5年のタイムスパンで算出し、NPV(正味現在価値)、IRR(内部収益率)、回収期間を算出します。重要なのは短期的効果だけでなく、競争優位性確保、デジタル変革基盤構築、将来の拡張性などの長期的価値も含めた総合的な評価を行うことです。

大規模言語モデルの将来展望と市場動向

次世代LLMの技術革新予測

次世代LLMの技術進歩は、計算効率の向上、マルチモーダル統合の深化、専門性の特化という3つの方向性で進展すると予測されます。計算効率では、モデル圧縮技術、量子化手法、知識蒸留技術の進歩により、現在の1/10の計算リソースで同等性能を実現する軽量化が進みます。マルチモーダル統合では、テキスト・画像・音声・動画を統一的に処理するモデルが主流となり、現実世界の複雑な情報を包括的に理解・生成できるようになります。専門性特化では、医療、法務、金融、製造業などの特定分野に最適化されたドメイン特化型LLMが発展し、専門家レベルの知識と判断能力を提供します。技術的ブレークスルーとして、人間の推論プロセスを模倣するChain-of-Thought推論の高度化、リアルタイム学習による継続的な知識更新、因果関係理解の向上による論理的一貫性の強化などが期待されています。これらの進歩により、2030年頃には現在の汎用人工知能(AGI)に近い能力を持つLLMの実用化が予想されます。

ビジネス環境・働き方への構造的影響

LLMの普及は、従来の業務プロセスと組織構造に根本的な変革をもたらし、新しい働き方のパラダイムを創出しています。知識労働者の役割は、情報処理や文書作成から戦略立案、創造的問題解決、対人関係構築へとシフトし、LLMとの協働による生産性の飛躍的向上が実現します。組織構造では、中間管理層の一部機能がLLMに代替される一方、AI活用を前提とした新しい職種(プロンプトエンジニア、AI品質管理者、人間-AI協働コーディネーターなど)が創出されます。意思決定プロセスでは、LLMによる大量データ分析と複数シナリオ予測に基づく、より迅速で精度の高い経営判断が可能になります。リモートワークとの親和性も高く、地理的制約を超えた グローバルな人材活用と、個人の専門性を最大化するハイブリッド働き方が一般化します。企業競争力の源泉は、LLMをいかに効果的に活用し、人間の創造性と組み合わせるかにシフトし、デジタル変革の成否が事業存続を左右する時代になると予測されます。

新興活用領域と未来のユースケース

LLM技術の成熟に伴い、従来は困難とされていた領域での革新的な活用が期待されています。科学研究分野では、文献レビューの自動化、仮説生成支援、実験計画の最適化、論文執筆支援により、研究開発サイクルの大幅な短縮が実現します。創薬分野では、分子構造と薬効の関係分析、副作用予測、臨床試験計画の最適化などにより、新薬開発期間の短縮と成功率向上が期待されます。都市計画・社会インフラでは、交通流最適化、エネルギー需給予測、災害対応計画策定などの複雑なシステム設計にLLMの高度な分析能力が活用されます。エンターテインメント分野では、個人の嗜好に完全適応したコンテンツ生成、インタラクティブストーリーテリング、バーチャルキャラクターとの深い対話体験が実現します。教育分野では、個人の学習スタイルと理解度に最適化されたカリキュラム自動生成、リアルタイム学習支援、多言語対応による グローバル教育の民主化が進展します。これらの新領域での活用により、社会全体の知的生産性とクリエイティビティの向上が実現されると予想されます。

社会インフラとしてのLLMの可能性

LLMは個別企業のツールから社会全体の基盤技術へと発展し、新しい デジタル社会インフラとしての役割を担うと予測されます。行政サービスでは、多言語対応の行政窓口、複雑な手続きの自動化、政策立案支援、市民との対話促進により、より効率的で親しみやすい公共サービスが実現します。医療制度では、診断支援、治療計画最適化、医療格差解消、予防医学推進により、国民の健康水準向上と医療費削減が期待されます。教育制度では、個別最適化教育、教師の負担軽減、生涯学習支援、職業訓練の高度化により、社会全体の人材育成機能が強化されます。司法制度では、法的文書の自動分析、判例検索の高度化、法的アドバイスの民主化により、法的サービスへのアクセス向上が実現します。経済システムでは、市場分析の高度化、金融リスク評価の精密化、新規事業創出支援により、より効率的で公正な経済活動が促進されます。社会インフラとしてのLLMは、デジタルデバイド解消、社会的包摂の推進、持続可能な発展の実現において重要な役割を果たし、より公平で豊かな社会の構築に貢献すると期待されています。

まとめ

大規模言語モデル活用の重要ポイント

大規模言語モデル(LLM)は、現代ビジネスにおける競争優位性確保と業務革新の重要な推進力となっています。技術的な理解では、Transformerアーキテクチャによる高度な文脈理解能力、自己注意機構による精密な言語処理、大規模データと計算資源による汎用的な言語能力の獲得が、従来技術を大幅に上回る性能を実現していることを認識することが重要です。ビジネス活用では、カスタマーサポート、コンテンツ制作、プログラミング支援、教育分野など多岐にわたる領域で、30-80%の業務効率向上と品質改善を実現できる可能性があります。導入戦略では、段階的なアプローチによりリスクを最小化しながら効果を最大化し、既存システムとの統合により投資保護を図ることが成功の鍵となります。継続的な技術進歩により、LLMの能力は今後も飛躍的に向上し、AGIに近い汎用人工知能の実現も視野に入ってきており、早期の戦略的導入が将来の競争力確保において決定的な要因となります。

導入検討時の必須チェック項目

LLM導入を成功させるためには、技術面、運用面、リスク面での包括的な事前検討が不可欠です。技術面では、自社の業務要件に適したモデル選定、既存システムとの互換性確認、必要な計算リソースとコストの算出、セキュリティ要件への適合性を詳細に評価する必要があります。運用面では、導入スケジュールと段階的展開計画、従業員教育とチェンジマネジメント戦略、継続的な性能監視と改善プロセス、技術サポート体制の確保が重要な検討項目となります。リスク面では、ハルシネーション対策、プロンプトインジェクション防止、著作権・知的財産権への配慮、AI規制とコンプライアンス対応を事前に計画する必要があります。投資対効果の測定では、定量的ROI算出に加えて、競争優位性向上、イノベーション創出、将来拡張性などの長期的価値を含めた総合評価を行うことが重要です。最も重要なのは、LLMを単なる効率化ツールではなく、事業戦略の核心要素として位置づけ、組織全体でのデジタル変革推進力として活用することです。

継続的学習と情報収集の推奨アプローチ

LLM分野の急速な技術進歩に対応するため、継続的な学習と情報収集体制の構築が企業の競争力維持に不可欠です。技術動向の把握では、主要AI企業(OpenAI、Google、Meta等)の公式発表、学術論文の定期的レビュー、業界カンファレンスへの参加により最新情報を収集します。実践的スキル向上では、ハンズオン研修による実際の操作経験、プロンプトエンジニアリング技術の習得、API活用による システム統合スキルの向上を図ります。組織的学習では、社内勉強会の定期開催、外部専門家との連携、他社事例研究、業界コミュニティへの参加により、組織全体の知識レベル向上を推進します。戦略的計画では、技術ロードマップの定期更新、競合分析の継続実施、新技術の実証実験、長期投資計画の見直しを通じて、変化に対応できる柔軟な戦略を維持します。情報源として、技術ブログ、専門メディア、研究機関のレポート、コンサルティング会社の調査資料などを組み合わせて活用し、多角的な視点からLLM分野の動向を把握することが推奨されます。

“`

※本記事にはAIが活用されています。編集者が確認・編集し、可能な限り正確で最新の情報を提供するよう努めておりますが、AIの特性上、情報の完全性、正確性、最新性、有用性等について保証するものではありません。本記事の内容に基づいて行動を取る場合は、読者ご自身の責任で行っていただくようお願いいたします。本記事の内容に関するご質問、ご意見、または訂正すべき点がございましたら、お手数ですがお問い合わせいただけますと幸いです。