ChatGPTと大規模言語モデルの違いとは?仕組みから活用法まで徹底解説

この記事は、ChatGPTと大規模言語モデル(LLM)の違いと関係性を基礎から整理し、仕組み・進化・日本語特化型モデルの必要性までを体系的に解説しています。

さらに、ビジネス導入のフレームワークやROI算出、セキュリティ対策、業界別活用事例を具体的に紹介し、実践的な指針を提示しています。

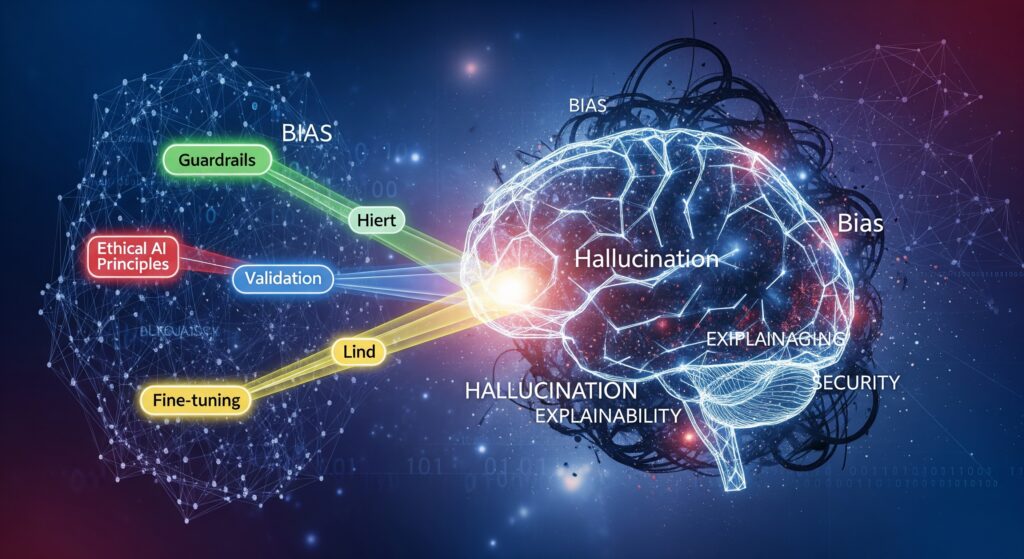

最後に、ハルシネーションやバイアスへの対策、AGIやマルチモーダルAIの未来展望を示し、責任あるAI活用と将来のビジネスインパクトについてまとめています。

<br> body { font-family: ‘Hiragino Sans’, ‘Yu Gothic’, sans-serif; line-height: 1.8; margin: 0; padding: 20px; max-width: 1200px; margin: 0 auto; }<br /><br> h1 { color: #2c3e50; border-bottom: 3px solid #3498db; padding-bottom: 10px; }<br /><br> h2 { color: #34495e; border-left: 5px solid #3498db; padding-left: 15px; margin-top: 40px; }<br /><br> h3 { color: #2c3e50; margin-top: 30px; }<br /><br> h4 { color: #34495e; margin-top: 25px; }<br /><br> .has-inline-color.has-swl-main-color { color: #e74c3c; }<br /><br> mark.has-inline-color.has-swl-main-color { background-color: #fff3cd; color: #e74c3c; padding: 2px 4px; border-radius: 3px; }<br /><br> strong { color: #2c3e50; }<br /><br> ul, ol { margin: 15px 0; padding-left: 25px; }<br /><br> li { margin: 8px 0; }<br /><br> p { margin: 15px 0; text-align: justify; }<br /><br> .intro-section { background-color: #f8f9fa; padding: 25px; border-radius: 8px; margin: 20px 0; border-left: 5px solid #3498db; }<br /><br> .toc { background-color: #ecf0f1; padding: 20px; border-radius: 8px; margin: 30px 0; }<br /><br> .toc h3 { margin-top: 0; color: #2c3e50; }<br /><br> .toc ul { list-style: none; padding-left: 0; }<br /><br> .toc li { margin: 5px 0; }<br /><br> .toc a { text-decoration: none; color: #3498db; }<br /><br> .toc a:hover { text-decoration: underline; }<br /><br> .highlight-box { background-color: #e8f6ff; padding: 20px; border-radius: 8px; margin: 20px 0; border-left: 4px solid #3498db; }<br /><br> .summary-box { background-color: #f0f8f0; padding: 20px; border-radius: 8px; margin: 30px 0; border-left: 4px solid #27ae60; }<br /><br>

ChatGPTの急速な普及により、「大規模言語モデル」という言葉を耳にする機会が増えました。しかし、ChatGPTと言語モデルの関係性や違いについて正確に理解している方は意外と少ないのではないでしょうか。

大規模言語モデル(LLM)とは、膨大なテキストデータを学習し、人間のような自然な文章生成を可能にするAI技術の基盤です。ChatGPTはこのLLM技術を活用して開発された対話特化型のAIサービスであり、両者には明確な違いと関係性があります。

本記事では、ChatGPTと言語モデルの技術的仕組みから実践的な活用方法まで、AI初心者の方でも理解できるよう体系的に解説します。国産LLMの最新動向やプロンプトエンジニアリングの実践テクニックも詳しく紹介しますので、ビジネスでのAI活用をお考えの方もぜひ参考にしてください。

目次

1. ChatGPTと大規模言語モデル(LLM)の基本概念

1-1. ChatGPTの定義と特徴

ChatGPTとは、OpenAI社が開発した対話型人工知能システムです。2022年11月にリリースされ、わずか2ヶ月で1億人のユーザーを獲得した革新的なAIサービスとして世界中の注目を集めました。

ChatGPTの最大の特徴は、人間との自然な対話を実現することです。従来のチャットボットとは異なり、文脈を理解し、複雑な質問に対しても人間らしい回答を生成できます。また、文章作成、翻訳、プログラミング、創作活動など、幅広いタスクに対応可能な汎用性も持ち合わせています。

現在提供されているChatGPTには、無料版のGPT-3.5と有料版のGPT-4があり、それぞれ異なる性能と機能を提供しています。GPT-4では画像認識機能も追加され、テキストと画像を組み合わせたマルチモーダル処理が可能になっています。

1-2. 大規模言語モデル(LLM)とは何か

大規模言語モデル(Large Language Model:LLM)とは、膨大な量のテキストデータを学習して構築された人工知能モデルです。数百億から数兆個のパラメータを持つニューラルネットワークにより、人間の言語を理解し、自然な文章を生成する能力を獲得しています。

LLMの基本的な仕組み

LLMは「次に来る単語を予測する」という単純な原理に基づいて動作します。大量のテキストデータから単語の出現パターンを学習し、与えられた文脈に最も適した次の単語を確率的に選択します。この処理を繰り返すことで、まとまりのある自然な文章を生成できるのです。

例えば、「今日の天気は」という入力に対して、学習データから「晴れ」「曇り」「雨」などの単語が続く確率を計算し、最も適切な単語を選択して「今日の天気は晴れです」のような文章を生成します。

LLMの特徴と能力

現代のLLMは以下のような特徴を持っています:

- 文脈理解能力:長い文章の流れを把握し、一貫性のある回答を生成

- 多言語対応:複数の言語での処理が可能

- 汎用性:特定のタスクに限定されない幅広い応用が可能

- 創発能力:学習していない新しいタスクも実行できる能力

1-3. ChatGPTとLLMの関係性と位置づけ

ChatGPTとLLMの関係は、「LLMという技術基盤の上に構築されたサービスがChatGPT」として理解できます。LLMは技術そのものであり、ChatGPTはその技術を活用した具体的なアプリケーションなのです。

具体的な関係性

OpenAIが開発したGPT(Generative Pre-trained Transformer)シリーズというLLMをベースに、対話に特化した追加学習を行ったものがChatGPTです。つまり、ChatGPTは「対話特化型のGPT」と言えるでしょう。

この関係性は、自動車とエンジンの関係に例えることができます。エンジン(LLM)は動力源であり、それを搭載した完成車(ChatGPT)が実際にユーザーが利用するサービスということです。

市場における位置づけ

ChatGPTは数多く存在するLLMベースのサービスの中でも、特に対話性能に優れ、ユーザーフレンドリーなインターフェースを持つサービスとして位置づけられています。Google Bard、Anthropic Claude、Microsoft Copilotなど、他社も同様のサービスを提供していますが、ChatGPTは先行者として大きな市場シェアを獲得しています。

1-4. 生成AIにおけるLLMの役割

生成AI(Generative AI)とは、新しいコンテンツを生成できるAI技術の総称です。テキスト、画像、音声、動画など様々な形式のコンテンツを生成できますが、その中でテキスト生成を担当するのがLLMです。

生成AIエコシステムにおけるLLMの位置

現在の生成AIエコシステムでは、以下のような役割分担があります:

- テキスト生成:LLM(GPT、Claude、LLaMAなど)

- 画像生成:拡散モデル(DALL-E、Midjourney、Stable Diffusionなど)

- 音声生成:音声合成モデル(ElevenLabs、Murf.aiなど)

- 動画生成:動画生成モデル(Runway、Pikaなど)

LLMは単独でテキスト生成を行うだけでなく、他の生成AIモデルと連携してマルチモーダルなサービスを提供する中核的な役割も果たしています。ChatGPTの最新版では、テキストだけでなく画像の理解と生成も可能になっており、LLMを中心とした統合的な生成AI体験を提供しています。

ビジネスインパクト

LLMの登場により、コンテンツ制作、カスタマーサポート、教育、プログラミングなど、あらゆる分野でテキスト処理の自動化が進んでいます。企業は人間が行っていた文章作成業務をLLMに置き換えることで、効率化とコスト削減を実現しています。

2. 大規模言語モデルの技術的仕組み

2-1. 言語モデルの基本原理と予測メカニズム

言語モデルの基本原理は、「確率的言語予測」にあります。人間が日常的に使用する言語のパターンを大量のテキストデータから学習し、与えられた文脈に対して最も適切な次の単語を予測する仕組みです。

統計的アプローチの進化

従来の言語モデルでは、N-gramと呼ばれる統計的手法が主流でした。これは直前のN個の単語から次の単語を予測する手法です。しかし、この方法では長期的な文脈を把握することが困難でした。

現代のLLMでは、ニューラルネットワークを使用することで、はるかに長い文脈を考慮した予測が可能になっています。数千から数万トークン(単語や文字の単位)にわたる文脈を同時に処理し、より自然で一貫性のある文章生成を実現しています。

学習プロセスの詳細

LLMの学習は主に以下の段階で行われます:

- 事前学習(Pre-training):大量の未加工テキストデータで基本的な言語理解を学習

- 教師あり微調整(Supervised Fine-tuning):高品質な対話データで特定タスクに最適化

- 強化学習(Reinforcement Learning):人間のフィードバックを基にさらなる改善

2-2. Transformerアーキテクチャの革新性

現代のLLMの基盤となっているのが、2017年にGoogleの研究チームが発表したTransformerアーキテクチャです。「Attention Is All You Need」という論文で紹介されたこの技術は、自然言語処理の分野に革命をもたらしました。

Attentionメカニズムの仕組み

Transformerの中核となるAttentionメカニズムは、文章内の各単語が他の単語とどの程度関連しているかを動的に計算します。従来の手法では単語を順番に処理していましたが、Attentionにより全ての単語を同時に処理し、重要な関係性を効率的に捉えることができるようになりました。

例えば、「彼は本を読んだ」という文章において、「彼」が誰を指すのかを判断する際、Attentionメカニズムは文脈全体を参照して最適な解釈を行います。長い文章であっても、遠く離れた単語間の関係性を正確に把握できるのです。

並列処理による効率化

Transformerアーキテクチャのもう一つの革新は、並列処理の実現です。従来の手法では単語を順次処理する必要がありましたが、Transformerでは全ての単語を同時に処理できるため、学習と推論の大幅な高速化が実現されました。

2-3. トークン化から文章生成までのプロセス

LLMが文章を生成する過程は、複数の段階に分けて理解することができます。トークン化から始まり、エンコーディング、予測、デコーディングという一連の処理を経て、最終的な文章が生成されます。

1. トークン化(Tokenization)

入力されたテキストは、まずトークンと呼ばれる小さな単位に分割されます。日本語の場合、文字、単語、または文字の組み合わせがトークンとなります。例えば、「ChatGPTは便利です」は「Chat」「GPT」「は」「便利」「です」のようにトークン化されます。

2. エンコーディング(Encoding)

トークン化されたテキストは、数値ベクトルに変換されます。この過程で、各トークンの意味や文脈における位置情報がベクトルとして表現されます。このベクトル表現により、コンピュータが言語の意味を数学的に処理できるようになります。

3. 予測と生成

エンコードされた情報を基に、Transformerネットワークが次に来るべきトークンの確率分布を計算します。最も確率の高いトークンが選択され、これが生成される文章の一部となります。この処理を繰り返すことで、完全な文章が生成されます。

4. デコーディング(Decoding)

生成されたトークン列は、最終的に人間が読める自然言語に変換されます。この段階で、適切な句読点や改行が挿入され、読みやすい形式の文章として出力されます。

2-4. パラメータ数が性能に与える影響

LLMの性能を決定する重要な要素の一つがパラメータ数です。パラメータとは、ニューラルネットワーク内で学習される重みや偏向の値のことで、その数が多いほど複雑なパターンを学習できる傾向があります。

パラメータ数の進化

GPTシリーズの進化を見ると、パラメータ数の劇的な増加が確認できます:

- GPT-1(2018年):1.17億パラメータ

- GPT-2(2019年):15億パラメータ

- GPT-3(2020年):1,750億パラメータ

- GPT-4(2023年):推定1兆パラメータ以上

この指数関数的な増加により、モデルの表現力と性能が大幅に向上しています。しかし、パラメータ数の増加は計算コストの増大も意味するため、効率性とのバランスが重要な課題となっています。

スケーリング法則

OpenAIの研究により、モデルサイズ、データセット規模、計算量の間には明確なスケーリング法則が存在することが明らかになっています。これらの要素を適切にスケールアップすることで、予測可能な性能向上が実現できることが示されています。

ただし、近年の研究では、単純なパラメータ数の増加よりも、学習データの質の向上や学習手法の改善の方が効果的である場合もあることが分かってきています。これにより、より効率的で実用的なLLMの開発が進められています。

3. ChatGPTの技術的進化と独自性

3-1. GPTシリーズの発展史(GPT-1からGPT-4まで)

ChatGPTの基盤となるGPTシリーズは、2018年から継続的に進化を続けており、各世代で革新的な改善を実現してきました。この発展史を理解することで、現在のChatGPTの高性能な対話能力がどのように実現されたかを把握できます。

GPT-1(2018年):基盤技術の確立

初代GPTは1.17億パラメータを持つモデルとして登場し、Transformerアーキテクチャを言語生成タスクに初めて本格適用しました。事前学習と微調整(Pre-training & Fine-tuning)のアプローチを確立し、単一のモデルで複数の自然言語処理タスクに対応できることを実証しました。当時としては画期的でしたが、生成される文章は短く、長期的な一貫性には課題がありました。

GPT-2(2019年):スケールアップの効果

GPT-2では15億パラメータに大幅に拡張され、生成文章の品質が劇的に向上しました。40GBのWebテキストデータで学習され、人間が書いたような自然な文章の生成が可能になりました。OpenAIは当初、悪用の懸念から完全版の公開を控えるほど、その性能の高さが注目されました。Zero-shot学習能力も向上し、特定のタスクに特化した学習なしでも様々な言語タスクを実行できるようになりました。

GPT-3(2020年):ブレイクスルーの実現

1,750億パラメータのGPT-3は、真のブレイクスルーとなりました。570GBの学習データと3,000億語の単語数により、人間レベルの文章生成能力を獲得しました。Few-shot学習により、数個の例を示すだけで新しいタスクを実行できるようになり、汎用性が大幅に向上しました。この時点で、ニュース記事の生成において人間との判別が困難なレベルに到達し、創作、翻訳、要約など幅広い分野での実用性が実証されました。

GPT-4(2023年):マルチモーダル化と精度向上

GPT-4では推定1兆パラメータ以上の規模となり、テキストと画像を同時に処理できるマルチモーダル機能を実装しました。米国司法試験で上位10%の成績を収めるなど、専門的な推論能力も大幅に向上しています。また、最大32,768トークン(約50ページ分)の長い文脈を処理できるようになり、長文の理解と生成能力が飛躍的に改善されました。

3-2. 人間からのフィードバック学習(RLHF)の重要性

ChatGPTの対話性能を支える重要な技術が、人間からのフィードバックによる強化学習(Reinforcement Learning from Human Feedback:RLHF)です。この手法により、従来のLLMでは実現困難だった「人間にとって有用で安全な回答」の生成が可能になりました。

RLHFの実装プロセス

RLHFは以下の3段階で実装されます。第1段階では、人間のトレーナーが高品質な対話例を作成し、これらでGPT-3を微調整します。第2段階では、複数の回答候補に対して人間が品質順位を付け、報酬モデルを学習させます。第3段階では、この報酬モデルを使用してPPO(Proximal Policy Optimization)アルゴリズムにより、より良い回答を生成するようモデルを最適化します。

従来手法との違い

従来のLLMは「次の単語を正確に予測する」ことに特化していましたが、RLHFにより「人間にとって有用で適切な回答をする」ことを学習できるようになりました。これにより、単に文法的に正しいだけでなく、倫理的で建設的な対話が可能になっています。

継続的改善システム

ChatGPTでは、ユーザーからの評価フィードバック(thumbs up/down)を収集し、継続的にモデルの改善を行っています。この仕組みにより、実際の使用状況に基づいた実用的な改善が継続されています。

3-3. ChatGPTの対話特化型最適化

ChatGPTは単なるテキスト生成ツールではなく、対話に特化した最適化が施されています。この最適化により、ユーザーとの自然で建設的な対話を実現し、従来のチャットボットとは一線を画す体験を提供しています。

対話文脈の維持機能

ChatGPTは会話履歴を記憶し、前の発言内容を参照して一貫性のある対話を継続できます。例えば、「先ほど話した件について詳しく教えて」のような曖昧な参照であっても、文脈から適切に理解して回答します。この機能により、人間同士の自然な会話に近い体験が実現されています。

役割適応能力

ChatGPTは指示された役割や専門性に応じて、回答スタイルや内容を適応させることができます。プログラミングの質問には技術的で詳細な回答を、創作活動の相談には創造性を重視した回答を提供するなど、文脈に応じた適切な対応が可能です。

安全性と有用性のバランス

対話特化の最適化には、有害コンテンツの生成を防ぐ安全機能も含まれています。違法行為の手順や差別的内容の生成を拒否しつつ、教育的で建設的な情報提供は行うという、微妙なバランスを実現しています。

3-4. マルチモーダル機能の実現

GPT-4以降のChatGPTでは、テキストだけでなく画像の理解と生成も可能なマルチモーダル機能が実装されています。これにより、より豊かで実用的なAI体験が提供されています。

画像理解機能

ChatGPTは画像をアップロードすると、その内容を詳細に分析し、説明することができます。写真に写っている物体の識別、図表やグラフの読み取り、手書きメモのテキスト化など、様々な画像処理タスクに対応しています。例えば、レシートの写真をアップロードして家計簿の作成を依頼したり、手書きのスケッチからWebページのコードを生成することも可能です。

画像生成機能(DALL-E 3統合)

ChatGPT Plus版では、DALL-E 3との統合により、テキストの指示から高品質な画像を生成できます。詳細な説明を提供するだけで、プロフェッショナルレベルの画像が作成され、マーケティング資料やプレゼンテーション素材の作成に活用されています。

音声対話機能

2023年9月には音声対話機能も追加され、自然な音声での会話が可能になりました。高品質な音声合成により、まるで人間と話しているような体験を提供し、視覚障害者や運転中のユーザーなど、テキスト入力が困難な状況でも利用できるようになっています。

統合的なユーザー体験

これらのマルチモーダル機能は独立して動作するのではなく、統合的なユーザー体験を提供します。例えば、画像について音声で質問し、テキストと画像で回答を受け取るといった、複数のモダリティを組み合わせた自然な対話が可能になっています。この統合性により、ChatGPTは単なるツールから、より人間らしいAIアシスタントへと進化を遂げています。

4. ChatGPTと他の大規模言語モデルの比較

4-1. ChatGPTの独自性と競合優位性

ChatGPTが市場で圧倒的な支持を獲得している理由は、その独自の技術的優位性と戦略的な差別化にあります。単なる技術力だけでなく、ユーザビリティ、エコシステム、継続的改善の仕組みにおいて他のLLMサービスとは一線を画しています。

対話最適化への徹底した取り組み

ChatGPTの最大の強みは、対話体験への徹底的な最適化です。RLHFによる人間らしい応答パターンの学習、文脈保持能力の向上、安全性と有用性のバランス調整など、対話専用の改良が重ねられています。他のLLMが汎用的な言語処理能力を重視する中、ChatGPTは「人間との対話」に特化した進化を続けています。

ユーザーフレンドリーなインターフェース

技術的な優秀さだけでなく、シンプルで直感的なユーザーインターフェースもChatGPTの大きな競合優位性です。専門知識がなくても簡単に使い始められる設計により、一般ユーザーから専門家まで幅広い層の支持を獲得しています。また、モバイルアプリの提供やAPIの充実により、様々な利用シーンに対応しています。

継続的なモデル更新とフィードバックシステム

ChatGPTは定期的なモデル更新により、性能改善を継続しています。ユーザーからのフィードバックを積極的に収集し、実際の使用パターンに基づいた改善を行っているため、理論上の性能だけでなく実用性の向上も実現されています。

4-2. Google Bard、Claude、Geminiとの違い

ChatGPTの主要な競合他社として、Google、Anthropic、Metaなどがそれぞれ特色のあるLLMサービスを提供しています。各サービスの特徴と違いを理解することで、用途に応じた最適な選択が可能になります。

Google Bard(Geminiベース)

Google BardはGeminiモデルをベースとしており、Googleの膨大な検索データと知識グラフを活用した情報提供が特徴です。リアルタイムのWeb検索結果を参照できるため、最新情報への対応力でChatGPTを上回る場合があります。また、Googleのエコシステム(Gmail、Google Drive、Google Sheetsなど)との連携機能も強力です。

一方で、対話の自然さや創作能力においては、ChatGPTに劣る場合が多く見られます。また、安全性を重視するあまり、創作や仮定的な質問に対して過度に慎重な回答をする傾向があります。

Anthropic Claude

ClaudeはAI安全性の研究で知られるAnthropic社が開発したLLMで、特に倫理的で安全な回答に重点を置いています。Constitutional AIという手法により、有害コンテンツの生成を抑制しつつ、建設的で誠実な対話を実現しています。

長文の処理能力も優秀で、最大100,000トークン(約75,000語)の文脈を処理できるため、長い文書の分析や要約に適しています。ただし、創作活動や娯楽的な用途では、ChatGPTほどの柔軟性を持たない場合があります。

Google Gemini Pro/Ultra

2023年12月に発表されたGeminiは、Googleの最新LLMとして、マルチモーダル機能とコーディング能力に優れています。特に数学的推論やプログラミングタスクにおいて高い性能を示しており、技術的な専門性を要求される用途に適しています。

しかし、一般的な対話体験や創作活動においては、ChatGPTの方が自然で魅力的な回答を提供する場合が多いとされています。

4-3. オープンソースLLMとの比較

商用サービスに対して、オープンソースLLMも急速に発展しており、企業の自社システム構築や研究開発において重要な選択肢となっています。代表的なオープンソースLLMとChatGPTとの比較を行います。

Meta LLaMA 2/3

Metaが開発したLLaMAシリーズは、商用利用も可能なオープンソースLLMとして高い注目を集めています。70億、130億、700億パラメータの複数バリエーションが提供され、企業の計算リソースに応じた選択が可能です。

自社環境で運用できるため、データプライバシーの確保やカスタマイズの自由度が高い一方で、運用コストやメンテナンスの負担は企業側が負う必要があります。性能面では、適切に微調整されたLLaMAモデルはChatGPTに匹敵する場合もありますが、一般的な対話体験ではChatGPTが優位とされています。

Mistral AI

フランスのMistral AIが開発するオープンソースLLMは、効率性と性能のバランスに優れています。比較的小さなモデルサイズでありながら、高い性能を実現しており、リソース制約のある環境での利用に適しています。

オープンソースLLMの利点と課題

オープンソースLLMの主な利点は以下の通りです:

- データプライバシーの完全な制御

- カスタマイズの自由度

- ランニングコストの管理

- ベンダーロックインの回避

一方で、以下のような課題もあります:

- 初期導入コストと技術的専門知識の必要性

- 継続的なメンテナンスとアップデートの負担

- 一般的な対話品質がChatGPTに劣る場合

- 安全性対策の自社実装が必要

4-4. 用途別最適モデルの選び方

LLMの選択は、具体的な用途と要件に応じて行うべきです。以下に主要な用途別の推奨モデルと選択基準を示します。

一般的な対話・質問応答

日常的な質問応答や一般的な情報収集には、ChatGPTが最も適しています。自然な対話体験と幅広い知識領域への対応力により、最も汎用性の高い選択肢となります。特に創作活動やブレインストーミングには、ChatGPTの創造性が有効です。

最新情報の検索・確認

リアルタイムの情報検索が必要な場合は、Google Bardが優位です。Web検索機能により最新のニュースやデータにアクセスできるため、時事問題や市場動向の確認に適しています。

長文分析・文書処理

長い文書の分析や要約には、Anthropic Claudeが最適です。100,000トークンの文脈処理能力により、学術論文や法的文書の分析に威力を発揮します。

プログラミング・技術支援

コーディング支援や技術的な問題解決には、ChatGPT-4やGoogle Gemini Proが適しています。特にGitHub Copilotと連携したChatGPTは、開発ワークフローとの統合性に優れています。

企業システム統合

企業の既存システムとの統合や大規模展開には、オープンソースLLM(LLaMA、Mistralなど)の検討が必要です。初期投資と運用コストを慎重に評価し、技術的な要件と合わせて選択することが重要です。

選択基準のフレームワーク

LLM選択時に考慮すべき主要な基準:

- 用途の特殊性:一般対話 vs 専門タスク

- データプライバシー要件:クラウド vs オンプレミス

- コスト構造:初期費用 vs ランニングコスト

- 技術的要件:API統合 vs 独立運用

- 安全性・コンプライアンス:業界規制への対応

5. 日本語対応LLMの現状と課題

5-1. 日本語特化型LLMの必要性と背景

ChatGPTをはじめとする海外製LLMの多くは英語を中心に学習されているため、日本語特有の課題に対して十分な対応ができない場合があります。このため、日本語に特化したLLMの開発が急務となっています。

日本語の言語的複雑性

日本語は世界的に見ても特に複雑な言語構造を持っています。ひらがな、カタカナ、漢字という3つの文字体系が混在し、同じ漢字でも読み方や意味が文脈によって変化します。また、敬語システムの複雑さ、助詞による語順の柔軟性、省略が多用される文構造など、機械学習にとって困難な要素が数多く存在します。

さらに、「空気を読む」「察する」といった日本文化特有のコミュニケーション様式は、明示的でない情報を適切に理解する能力を要求します。これらの特徴により、英語中心のLLMでは日本語の微妙なニュアンスや文化的背景を完全に理解することが困難です。

ビジネス要件と文化的適応

日本企業がLLMを活用する際、単なる翻訳精度だけでなく、日本のビジネス慣習や文化に適応した対応が求められます。例えば、顧客対応における適切な敬語の使用、稟議制度に対応した文書作成、季節の挨拶を含む日本的なコミュニケーションスタイルなど、文化的背景を理解したAI支援が必要です。

データ主権とプライバシー

企業や政府の機密情報を海外のAIサービスに送信することへの懸念も、国産LLM需要の背景にあります。データの国外流出リスクを回避し、日本の法規制に完全に準拠したAIサービスへの需要が高まっています。

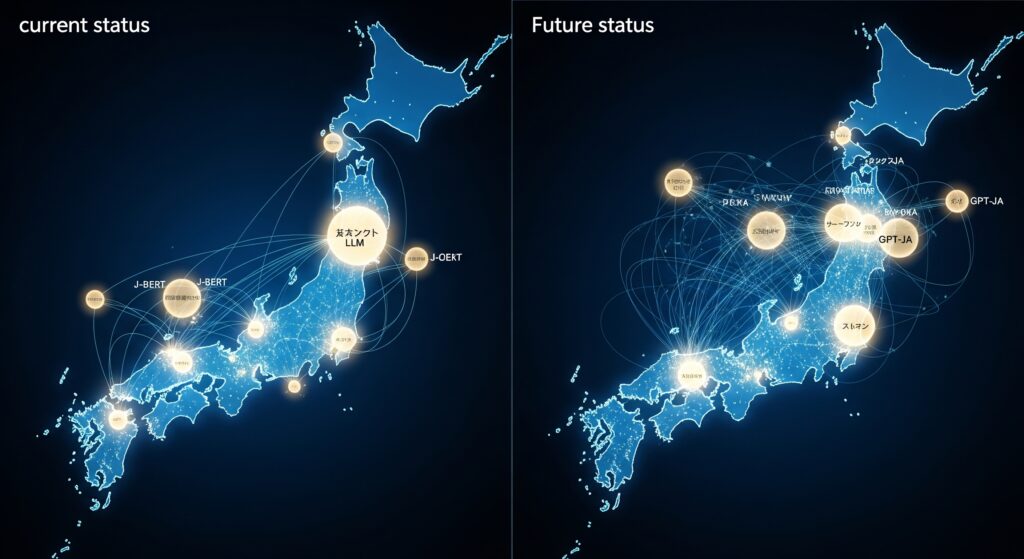

5-2. 国産LLMの最新動向(サイバーエージェント、NTT、リコー等)

2024年から2025年にかけて、日本企業による独自LLM開発が急速に進展しています。各社が異なるアプローチで日本語特化型LLMの開発を進めており、実用化段階に入ったモデルも登場しています。

サイバーエージェント「CyberAgentLM3」

サイバーエージェントは2024年7月に225億パラメータの日本語LLM「CyberAgentLM3-22B-Chat」を公開しました。このモデルは既存モデルをベースとせず、完全にスクラッチから開発された点が特徴です。日本語能力を評価するNejumi LLMリーダーボードにおいて、700億パラメータのMeta-Llama-3-70B-Instructと同等の性能を達成しており、効率性と性能を両立しています。

商用利用可能なApache License 2.0で提供されており、同社の「極予測AI」をはじめとする実際のサービスで活用されています。継続的な改善により、2023年の初代モデルから大幅な性能向上を実現しています。

NTT「tsuzumi」

NTTが開発した「tsuzumi」は、軽量でありながら高い日本語処理能力を持つことが特徴です。6億から70億パラメータという比較的小さなモデルサイズでありながら、日本語と英語の処理に特化した設計により、GPUやCPUでの効率的な推論が可能です。

特に企業向けのカスタマイズ性に優れており、特定の業界や企業に特化したチューニングが容易に行えます。メディカルやコンタクトセンター分野での先行トライアルを経て、2024年3月から商用サービスの提供を開始しています。

リコー独自LLM

リコーは130億パラメータの日本語精度の高いLLMを開発し、日本語ベンチマークツール(llm-jp-eval)において最高の評価スコアを獲得しました。Meta社のLlama2-13Bをベースに、独自の学習データ選定とカリキュラム学習により、特に自然言語推論能力(NLI)で高い性能を実現しています。

企業独自の情報や知識を取り入れることで、短期間でカスタムLLMを構築できることが特徴で、2024年春からクラウド環境でのサービス提供を開始しています。

ソフトバンクの大規模計算基盤

ソフトバンクは2024年内の3,500億パラメータ日本語特化国産LLM構築を目指し、国内最大級の生成AI開発向け計算基盤の構築を進めています。この基盤は段階的にグループ内で活用された後、大学や研究機関、企業への提供が予定されています。

5-3. 日本語処理における技術的課題

日本語LLMの開発には、言語固有の技術的課題が数多く存在します。これらの課題を理解することで、日本語LLMの性能向上の方向性と限界を把握できます。

トークン化の課題

日本語は単語間にスペースがないため、適切な単位でのトークン化が困難です。文字単位、形態素単位、サブワード単位など、複数のアプローチが存在しますが、それぞれに長所と短所があります。不適切なトークン化は、意味理解の精度低下や計算効率の悪化を招くため、日本語に最適化されたトークナイザーの開発が重要です。

文脈依存性の処理

日本語は主語や目的語の省略が頻繁に行われるため、文脈から省略された要素を推論する能力が必要です。また、同じ表現でも状況や関係性によって意味が変わる場合があり、高度な文脈理解能力が求められます。例えば、「そうですね」という表現は、同意、困惑、時間稼ぎなど、文脈によって全く異なる意味を持ちます。

敬語システムの複雑性

日本語の敬語システムは、尊敬語、謙譲語、丁寧語の3つに大別され、さらに細かい区分が存在します。相手との関係性、場面、話題によって適切な敬語レベルを選択する必要があり、この判断をAIが適切に行うことは非常に困難です。

学習データの量と質

英語に比べて日本語の高品質な学習データは限られており、特に対話データや専門分野のデータが不足しています。また、インターネット上の日本語テキストには品質のばらつきが大きく、ノイズの多いデータから有用な言語パターンを学習することが課題となっています。

5-4. 敬語・文脈理解の精度向上への取り組み

日本語LLMの実用性を高めるためには、敬語と文脈理解の精度向上が不可欠です。各研究機関と企業では、この課題に対して様々なアプローチで取り組んでいます。

敬語システムの体系的学習

敬語の適切な使用には、話者と聞き手の社会的関係、場面の公式度、話題の性質などを総合的に判断する能力が必要です。最新の日本語LLMでは、これらの要素を明示的に学習するため、敬語使用のルールベースと実際の使用例を組み合わせた学習データセットの構築が進められています。

文脈補完技術の向上

省略された主語や目的語を適切に補完するため、談話構造の理解を強化する研究が進んでいます。前後の文脈だけでなく、話題の流れや話者の意図を推測するモデルの開発により、より自然な日本語生成が可能になっています。

専門分野特化型の敬語モデル

ビジネス、医療、教育など、分野ごとに異なる敬語の使用パターンに対応するため、専門分野特化型のファインチューニングが行われています。例えば、医療分野では患者との対話における適切な敬語レベル、ビジネス分野では顧客対応や社内コミュニケーションでの敬語使用パターンが学習されています。

評価指標の開発

敬語や文脈理解の精度を客観的に評価するため、日本語特有の評価指標の開発も進められています。従来の機械翻訳評価指標では捉えきれない、日本語の自然さや適切性を測定する新しい指標により、より実用的なモデル改善が可能になっています。

継続学習とユーザーフィードバック

実際の使用環境でのフィードバックを活用した継続的な改善システムも構築されています。企業の実際の業務で使用される際の修正要求や改善提案を収集し、モデルの継続的な精度向上を図る仕組みが導入されています。これにより、理論的な性能だけでなく、実用性の観点からの改善も実現されています。

6. ビジネス活用における実践ガイド

6-1. 企業導入時の検討フレームワーク

ChatGPTや大規模言語モデルの企業導入を成功させるためには、体系的な検討フレームワークに基づいた計画的なアプローチが不可欠です。技術的な側面だけでなく、組織、プロセス、リスク管理の観点を包括的に検討する必要があります。

導入目的の明確化

LLM導入の第一段階として、具体的な目的と期待効果を明確に定義することが重要です。単に「業務効率化」ではなく、「カスタマーサポートの応答時間を30%短縮」「文書作成業務のコストを40%削減」といった定量的な目標設定が必要です。また、短期的な効率化だけでなく、従業員のスキル向上や新しいサービス創出といった中長期的な価値創造も考慮すべきです。

適用領域の選定

LLMの特性を理解した上で、最適な適用領域を選定します。効果が期待できる領域として、定型的な文書作成、顧客からの問い合わせ対応、データ分析のサポート、創作活動の支援などがあります。一方で、法的判断、医療診断、財務決定など、高い専門性と責任が伴う領域では慎重な検討が必要です。

技術要件の定義

システム統合の観点から、API連携の要件、データフォーマット、セキュリティ仕様、可用性要件などを詳細に定義します。また、既存システムとの連携方法、ユーザーインターフェースの設計、モニタリング機能の実装なども検討対象となります。

組織的準備

技術導入と並行して、組織的な準備も重要です。LLM活用のためのガイドライン策定、従業員向けトレーニングプログラムの設計、新しいワークフローの構築、成果測定指標の設定などが必要です。特に、AI活用に対する従業員の理解と協力を得るための変革管理も重要な要素です。

6-2. ROI(投資対効果)の算出方法

LLM導入の投資対効果を正確に算出することで、経営判断の根拠を明確にし、継続的な改善につなげることができます。定量的な効果測定により、投資の妥当性を客観的に評価できます。

コスト要素の詳細分析

LLM導入に関わる総コストは以下の要素で構成されます。初期コストとして、ライセンス費用、システム統合費用、カスタマイズ費用、従業員トレーニング費用があります。運用コストには、月次利用料金、保守費用、継続的トレーニング費用、モニタリング費用が含まれます。

特にAPI利用型のサービスでは、利用量に応じた従量課金となるため、予想される利用パターンを詳細に分析し、年間の総利用コストを予測することが重要です。また、ピーク時の利用量増加や機能拡張による追加コストも考慮に入れる必要があります。

効果の定量化手法

LLM導入による効果は、直接的効果と間接的効果に分けて測定します。直接的効果には、作業時間の短縮による人件費削減、エラー率の減少による修正コストの削減、顧客対応の迅速化による満足度向上などがあります。

間接的効果として、従業員の創造的業務への集中による付加価値向上、新サービス開発の加速、顧客満足度向上による収益増加なども考慮します。これらの効果を金額換算するため、時間あたりの人件費、エラー修正にかかるコスト、顧客満足度と売上の相関関係などを詳細に分析します。

ROI計算の実践例

例として、年間売上100億円の企業でカスタマーサポート業務にChatGPTを導入する場合を考えます。導入コストが年間500万円、サポート担当者の作業効率が30%向上し、年間2,000万円の人件費削減が実現できれば、ROIは300%となります。さらに、応答品質向上による顧客満足度向上が売上の1%増加につながれば、追加で1億円の効果が期待できます。

6-3. セキュリティ・プライバシー対策の実装

LLMの企業利用において、セキュリティとプライバシー保護は最重要課題の一つです。機密情報の漏洩リスクを最小化し、法規制への準拠を確保する包括的な対策が必要です。

データ分類と取り扱いルール

まず、LLMに入力するデータを機密レベルに応じて分類し、それぞれに適した取り扱いルールを策定します。公開情報、社内情報、機密情報、極秘情報といった分類を行い、機密レベルの高い情報はLLMへの入力を禁止するか、特別な保護措置を講じます。

具体的には、個人情報、顧客データ、財務情報、技術仕様書、戦略文書などは、事前の匿名化処理や暗号化を行った上でのみ利用を許可します。また、従業員向けのガイドラインを作成し、どのような情報をLLMに入力してよいかを明確に示します。

技術的保護措置

システムレベルでの保護措置として、データの暗号化、アクセス制御、監査ログの実装が必要です。API通信の暗号化、データベースの暗号化、認証・認可システムの強化により、技術的なセキュリティレベルを向上させます。

また、LLMサービスとの通信においては、VPN接続の利用、IP制限の設定、アクセストークンの適切な管理などにより、不正アクセスのリスクを最小化します。オンプレミス型のLLMを利用する場合は、サーバーの物理セキュリティ、ネットワークセキュリティ、アプリケーションセキュリティの全層での対策が必要です。

法規制への対応

GDPR、個人情報保護法、業界固有の規制など、関連する法規制への準拠を確保します。特に、個人情報の越境移転に関する規制、データの保存期間や削除権への対応、監査要件への対応などが重要です。

金融業界のFISC安全対策基準、医療業界のガイドライン、政府機関の情報セキュリティポリシーなど、業界固有の要件にも適切に対応する必要があります。

6-4. 業界別活用事例と成功パターン

各業界において、LLMの特性を活かした独特の活用パターンが確立されています。成功事例を参考にすることで、自社の業界や規模に適した導入戦略を策定できます。

製造業での活用事例

製造業では、技術文書の作成と管理、品質管理データの分析、設備保守マニュアルの自動生成などでLLMが活用されています。ある大手自動車メーカーでは、過去の障害対応記録をLLMで分析し、新しい問題に対する解決策の提案システムを構築しました。これにより、技術者の問題解決時間が平均40%短縮され、設備稼働率の向上を実現しています。

また、多言語対応の技術マニュアル作成において、日本語から英語、中国語、タイ語などへの翻訳を自動化し、海外拠点での技術移転を効率化している事例もあります。

金融業界での活用事例

金融業界では、顧客からの問い合わせ対応、投資レポートの要約、規制文書の分析などでLLMが導入されています。ある地方銀行では、住宅ローンの相談において、顧客の質問をLLMが分析し、最適な商品提案と必要書類の案内を自動生成するシステムを導入しました。

この結果、相談員の負担が軽減され、顧客への提案品質が標準化されました。また、コンプライアンス確認においても、LLMが契約書や提案書の内容をチェックし、潜在的なリスクを早期発見する仕組みが構築されています。

医療・ヘルスケア業界での活用事例

医療分野では、診療記録の要約、医学文献の検索支援、患者への説明資料作成などでLLMが活用されています。ある大学病院では、医師の診療記録作成を支援するシステムを導入し、診療時間の短縮と記録の標準化を実現しました。

また、患者からの質問に対する初期回答システムとして、症状に関する一般的な情報提供や受診科の案内を自動化している事例もあります。ただし、医療分野では診断や治療方針の決定は必ず医師が行うという原則を厳守し、LLMは情報提供と業務支援に限定して活用されています。

小売・EC業界での活用事例

小売業界では、商品説明文の作成、顧客レビューの分析、個別化されたマーケティングメッセージの生成などでLLMが威力を発揮しています。ある大手ECプラットフォームでは、商品の特徴を入力するだけで、ターゲット顧客に合わせた魅力的な商品説明文を自動生成するシステムを構築しました。

この結果、出店者の商品登録時間が70%短縮され、統一された品質の商品説明により、顧客の購買決定を支援しています。また、顧客からの問い合わせに対する初期対応を自動化し、24時間体制でのカスタマーサポートを実現している事例もあります。

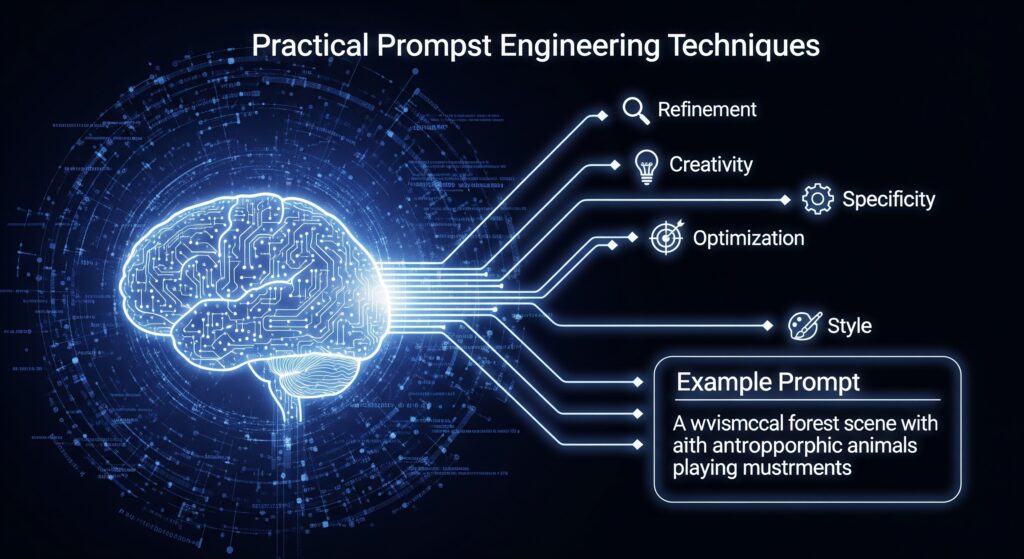

7. プロンプトエンジニアリングの実践テクニック

7-1. 効果的なプロンプト設計の基本原則

プロンプトエンジニアリングは、LLMから最適な回答を引き出すための重要なスキルです。適切なプロンプト設計により、同じLLMでも出力の品質が劇的に向上します。効果的なプロンプトには共通する設計原則があります。

明確性と具体性の原則

効果的なプロンプトの最も重要な要素は明確性です。曖昧な指示ではなく、具体的で詳細な指示を提供することで、意図した回答を得やすくなります。「文章を書いて」ではなく、「新商品のプレスリリースを300文字以内で、ターゲット顧客である30代女性向けに、環境配慮の特徴を強調して書いて」のように、目的、文字数、対象読者、重点ポイントを明確に指定します。

文脈情報の提供

LLMが適切な判断を行うために必要な背景情報や文脈を十分に提供します。業界特有の用語、企業文化、対象読者の特性、使用目的などの情報により、より適切で実用的な回答が得られます。例えば、「IT企業の人事担当者として、リモートワーク導入に関する社内向けガイドラインを作成する」という文脈を提供することで、より実践的な内容が生成されます。

出力形式の指定

求める回答の形式を明確に指定することで、すぐに利用可能な形での出力が得られます。「箇条書きで5項目」「表形式で比較」「JSON形式で出力」など、具体的な形式指定により、後工程での編集作業を最小化できます。

制約条件の明示

避けるべき内容、使用してはいけない表現、遵守すべきガイドラインなどの制約条件を明示します。これにより、コンプライアンス要件や企業ポリシーに準拠した回答が得られます。

7-2. Few-Shot、One-Shot、Zero-Shot学習の使い分け

LLMの学習パターンには、提供する例の数によって異なるアプローチがあります。タスクの複雑さや求める精度に応じて、最適な手法を選択することが重要です。

Zero-Shot学習の活用場面

Zero-Shot学習は、例を提供せずに指示のみでタスクを実行する手法です。一般的なタスクや、LLMが事前学習で十分な知識を持っている領域で効果的です。「この英文を日本語に翻訳して」「この商品の特徴を要約して」など、標準的なタスクに適用します。

Zero-Shotの利点は、プロンプトがシンプルで実装が容易なことです。また、トークン数が少ないため、コスト効率も良好です。ただし、複雑なタスクや特殊な形式での出力が必要な場合は、精度が不足する場合があります。

One-Shot学習の実践方法

One-Shot学習では、1つの具体例を提供してタスクの期待値を示します。特定の形式や品質レベルを求める場合に効果的です。例:「以下の例のような形式で商品説明文を作成してください。【例】商品名:○○、特徴:△△、ターゲット:××、価格:□□円」

One-Shotは、例の選択が結果に大きく影響するため、最も代表的で高品質な例を選択することが重要です。また、例が偏っていると、出力も偏る可能性があるため注意が必要です。

Few-Shot学習の効果的活用

Few-Shot学習では、複数の例(通常2-5個)を提供し、パターンを学習させます。複雑なタスクや、特殊な形式、微妙なニュアンスが必要な場合に最も効果的です。様々なパターンの例を提供することで、多様な入力に対して適切な出力を生成できます。

例:「以下の例を参考に、顧客の問い合わせに対する回答を作成してください。【例1】問い合わせ:返品方法 → 回答:お客様サポートページの返品ガイドをご確認ください。【例2】問い合わせ:配送状況 → 回答:注文番号をお教えいただければ配送状況をお調べいたします。【例3】問い合わせ:商品の詳細 → 回答:商品ページに詳細な仕様を記載しております。」

7-3. 業務別プロンプト最適化の具体例

各業務分野において、特化したプロンプト設計により、より実用的で高品質な出力が得られます。業務の特性を理解した上で、最適化されたプロンプトを設計することが重要です。

マーケティング業務での最適化

マーケティング分野では、ターゲット顧客の心理や行動パターンを考慮したプロンプト設計が重要です。「30代女性、年収400-600万円、都市部在住、環境意識高い」といった詳細なペルソナ情報を含めることで、より効果的なマーケティングコンテンツが生成されます。

具体例:「【ペルソナ】35歳女性、会社員、年収500万円、東京在住、2児の母、時短勤務、環境・健康志向【タスク】新発売のオーガニック食品の広告コピーを作成。【要件】SNS投稿用、150文字以内、共感を呼ぶ親しみやすいトーン、ハッシュタグ3個含む【制約】誇大表現禁止、薬事法遵守」

技術文書作成での最適化

技術文書では、正確性と理解しやすさのバランスが重要です。対象読者の技術レベルを明確に指定し、必要な詳細度を調整します。「新入社員向け」「経験者向け」「経営層向け」など、読者レベルを明確にすることで、適切な専門用語の使用レベルが調整されます。

具体例:「【対象読者】非技術系の経営層【タスク】AI導入プロジェクトの進捗報告書作成【要件】A4 1枚、図表なし、ビジネス価値に焦点、リスクと対策含む【形式】エグゼクティブサマリー形式【制約】専門用語は平易な言葉で説明、定量的データを重視」

カスタマーサポート業務での最適化

カスタマーサポートでは、顧客の感情に配慮した丁寧な対応と、迅速な問題解決の両立が求められます。顧客の状況(初回利用者、リピーター、苦情など)に応じたトーン調整が重要です。

具体例:「【状況】商品の不具合により困っている顧客からの苦情【顧客情報】リピーター、過去の購入履歴良好【タスク】謝罪と解決策の提示【要件】共感表現、具体的解決手順、再発防止策言及【トーン】誠実で親身、プロフェッショナル【制約】責任逃れの表現禁止、法的問題に言及しない」

7-4. プロンプトの品質評価と改善方法

プロンプトエンジニアリングは反復的な改善プロセスです。体系的な評価と改善により、継続的にプロンプトの品質を向上させることができます。

評価指標の設定

プロンプトの品質評価には、複数の指標を組み合わせて使用します。関連性(求める回答との一致度)、正確性(事実の正しさ)、完全性(必要な情報の網羅度)、使いやすさ(すぐに利用できる形式か)、一貫性(同様の入力に対する出力の安定性)などが主要な評価軸となります。

A/Bテストによる比較検証

複数のプロンプトバリエーションを作成し、同じタスクに対する出力品質を比較します。統計的に有意な差があるプロンプト要素を特定し、最適化に活用します。例えば、指示の順序、例の数、制約条件の表現方法などを変更したバリエーションでテストを行います。

段階的改善プロセス

プロンプト改善は以下の段階で進めます。第1段階:基本的なプロンプトで動作確認、第2段階:出力品質の問題点を特定、第3段階:問題点に対応する改善要素を追加、第4段階:改善効果を測定、第5段階:さらなる最適化ポイントを特定。この循環プロセスにより、継続的な品質向上を実現します。

ベストプラクティスの蓄積

効果的なプロンプトパターンをデータベース化し、組織内で共有します。業務別、用途別、品質レベル別にプロンプトテンプレートを整理し、再利用可能な形で管理します。また、失敗例も含めて記録することで、同様の問題を回避できます。定期的なレビューと更新により、組織全体のプロンプトエンジニアリング能力を向上させることができます。

8. 大規模言語モデルの課題と対策

8-1. ハルシネーション(幻覚)問題への対処法

ハルシネーション(幻覚)は、LLMが事実に基づかない情報を自信を持って生成してしまう現象です。この問題は、LLMの実用化において最も深刻な課題の一つであり、特にビジネス活用では信頼性を大きく損なう可能性があります。

ハルシネーションが発生する原因

ハルシネーションの主な原因は、LLMの基本的な動作メカニズムにあります。LLMは「もっともらしい次の単語」を予測して文章を生成するため、事実の正確性よりも言語的な自然さを優先する傾向があります。また、学習データに含まれる誤情報や偏った情報、学習データの不足している領域での推測による回答生成も原因となります。

特に、具体的な数値、固有名詞、最新の情報、専門的な技術情報などで発生しやすく、これらの情報を扱う際は特に注意が必要です。例えば、存在しない企業の売上高を具体的な数値で回答したり、実際には開催されていないイベントの詳細を創作したりする場合があります。

検出と防止の技術的手法

ハルシネーションへの対策として、複数の技術的アプローチが開発されています。まず、複数のLLMで同じ質問を処理し、回答の一致度を確認する手法があります。不一致が大きい回答は信頼性が低い可能性があります。

また、RAG(Retrieval-Augmented Generation)システムの導入により、信頼できる外部データソースから情報を取得し、それに基づいて回答を生成する手法も効果的です。これにより、生成される情報の根拠となるソースを明確にし、事実確認を容易にできます。

運用面での対策

技術的対策と並行して、運用面での対策も重要です。重要な意思決定に関わる情報については、必ず人間による確認を行うワークフローを構築します。また、LLMが生成した情報には「AI生成情報のため要確認」といった注意書きを付加し、利用者の注意を喚起します。

定期的な精度監査を実施し、特定の分野や種類の質問でハルシネーションが発生しやすいパターンを特定し、該当する質問に対しては特別な検証プロセスを適用することも効果的です。

8-2. バイアスと公平性確保のアプローチ

LLMは学習データに含まれる社会的バイアスを学習してしまうため、公平で偏見のない出力を確保することが重要な課題となっています。特に人事、採用、与信判断など、人の人生に影響を与える分野での利用では、バイアス対策が不可欠です。

バイアスの種類と影響

LLMに現れるバイアスには、性別バイアス(特定の職業を特定の性別と関連付ける)、人種・民族バイアス(特定の属性に対する偏見的表現)、地域バイアス(特定の地域に対する固定観念)、年齢バイアス(年齢に基づく偏見)などがあります。

これらのバイアスは、採用選考での不公平な評価、商品推薦での偏った提案、顧客対応での差別的な扱いなど、実際のビジネス場面で深刻な問題を引き起こす可能性があります。法的リスクだけでなく、企業の社会的信頼性にも大きな影響を与えます。

バイアス検出の手法

バイアスの検出には、体系的なテスト手法が開発されています。属性を変更した同様の質問を複数作成し、回答の差異を分析する対比テストが基本的な手法です。例えば、「男性の営業担当者」と「女性の営業担当者」について同じ質問をし、回答の違いを確認します。

また、多様な背景を持つ評価者チームによる定性的評価も重要です。異なる文化的背景や専門性を持つ評価者が、LLMの出力を多角的に検証することで、潜在的なバイアスを発見できます。

公平性向上の取り組み

バイアス軽減のためには、学習データの多様性確保が基本となります。特定の属性に偏らない、多様な視点を含む学習データを構築することで、バランスの取れた出力を促進します。

また、プロンプト設計時に公平性を意識した指示を含めることも効果的です。「性別、人種、年齢に関わらず公平に評価して」といった明示的な指示により、偏見のない回答を促すことができます。

8-3. 著作権・倫理的考慮事項への対応

LLMの商用利用において、著作権侵害リスクと倫理的課題への対応は法的・社会的責任として不可欠です。適切な対策により、法的リスクを回避し、社会的に責任ある AI活用を実現できます。

著作権侵害のリスクと対策

LLMが既存の著作物に酷似した内容を生成するリスクがあります。特に、文学作品、楽曲、映画脚本、特徴的な文章スタイルなどで問題となる可能性があります。対策として、生成されたコンテンツの独自性チェックツールの活用、類似性検索による既存著作物との比較確認が重要です。

また、商用利用時には、生成されたコンテンツが既存の著作物を侵害していないことを確認する法的レビュープロセスを設けることが推奨されます。特に出版、メディア、クリエイティブ業界での利用では、専門家による確認が不可欠です。

学習データの適法性確保

自社でLLMを学習させる場合、学習データの著作権処理が重要な課題となります。著作権者の許可を得たデータの使用、パブリックドメインやクリエイティブコモンズライセンスのデータの活用、フェアユース範囲内での利用などを慎重に検討する必要があります。

倫理ガイドラインの策定

組織内でのLLM利用に関する倫理ガイドラインを策定し、全従業員が遵守すべき基準を明確にします。人間の尊厳の尊重、多様性と包容性の促進、透明性の確保、説明責任の履行などが主要な要素となります。

特に、AIが人間の意思決定に影響を与える場面では、人間が最終的な判断を行うという原則を維持し、AIの提案や分析は参考情報として位置づけることが重要です。

8-4. 情報の正確性検証とファクトチェック

LLMが生成する情報の正確性を確保するため、体系的な検証プロセスの構築が不可欠です。特に、事実に基づく情報提供や意思決定支援にLLMを活用する場合、高い信頼性が要求されます。

多層的検証システム

情報の正確性確保には、複数の検証層を組み合わせたシステムが効果的です。第1層として、複数の信頼できるソースからの情報クロスチェック、第2層として、専門家による内容確認、第3層として、時系列での情報更新チェックを実施します。

また、情報の種類に応じた検証レベルの設定も重要です。事実情報(数値、日付、固有名詞)は高精度な検証、意見や分析は複数視点での妥当性確認、予測や推測は不確実性の明示といった形で、情報特性に応じた適切な検証を行います。

自動化された検証ツール

効率的な検証のため、自動化ツールの活用が進んでいます。信頼できるデータベースとの自動照合、数値情報の計算確認、日付や時系列の論理的整合性チェック、引用元の存在確認などが自動化可能な検証項目です。

ただし、自動化ツールには限界があるため、重要な情報については必ず人間による最終確認を行う体制を維持することが重要です。

継続的品質改善

検証プロセス自体の品質向上も継続的に行います。過去の誤情報事例の分析、検証ミスのパターン特定、検証プロセスの効率化、新しい検証技術の導入などにより、より高精度で効率的な検証システムを構築します。

また、ユーザーからのフィードバックや外部からの指摘を活用し、検証プロセスの改善点を特定します。定期的な検証精度の監査により、システム全体の信頼性を維持・向上させることができます。

透明性の確保

情報の正確性に関する透明性確保も重要な要素です。情報源の明示、検証プロセスの開示、不確実性レベルの表示、更新日時の記録などにより、利用者が情報の信頼性を適切に判断できるようにします。

また、誤情報が発覚した場合の迅速な修正・周知プロセスを確立し、継続的な信頼性向上に取り組む姿勢を示すことが、長期的な信頼関係構築につながります。

9. 未来展望と技術トレンド

9-1. AGI(汎用人工知能)への発展可能性

現在のLLMは、人間レベルの汎用的な知能を目指すAGI(Artificial General Intelligence)への重要なマイルストーンと位置づけられています。ChatGPTの登場により、AGI実現への道筋がより現実的になったとする専門家も多く存在します。

現在のLLMとAGIのギャップ

現在のLLMは特定分野では人間を上回る性能を示すものの、真の理解ではなく統計的なパターン認識に基づいているという限界があります。例えば、常識的推論、因果関係の理解、長期記憶の活用、創造的問題解決など、人間の知能の重要な側面でまだ課題を抱えています。

また、現在のLLMは主にテキスト処理に特化しており、物理世界との相互作用、感情の理解、社会的知能など、人間の知能の多面性を完全には再現できていません。これらのギャップを埋めることがAGI実現への課題となっています。

AGI実現への技術的アプローチ

AGI実現に向けて、複数の技術的アプローチが並行して進められています。まず、モデルサイズのさらなる拡大により、創発的能力の向上を目指すスケーリング仮説があります。一方で、モデル効率の改善により、同等の性能をより少ない計算資源で実現する効率化アプローチも重要です。

また、マルチモーダル統合により、テキスト、画像、音声、センサーデータなどを統合的に処理できるシステムの開発が進んでいます。さらに、推論能力の強化、長期記憶システムの実装、自律的学習機能の開発なども重要な研究領域となっています。

AGI実現の時期予測と影響

AI研究者の間でも、AGI実現時期については意見が分かれています。楽観的な予測では2030年代前半、保守的な予測では2050年以降とする見方があります。ただし、技術の指数関数的進歩を考慮すると、予想よりも早期の実現可能性も否定できません。

AGIが実現した場合の社会的影響は極めて大きく、労働市場の根本的変化、教育システムの再構築、経済構造の変革などが予想されます。これらの変化に備えて、社会制度や法制度の整備も重要な課題となります。

9-2. マルチモーダルAIの進化方向

現在のAI技術は、テキスト、画像、音声、動画などの異なるデータ形式を統合的に処理するマルチモーダルAIへと急速に進化しています。この技術により、より人間に近い総合的な理解と表現が可能になります。

統合的理解能力の向上

次世代のマルチモーダルAIでは、異なるモダリティ間の関係性をより深く理解できるようになります。例えば、画像に写っている物体と、それに関する音や説明テキストを関連付けて理解し、より豊かな文脈での応答が可能になります。

また、時系列データの統合により、動画コンテンツの理解、リアルタイム状況認識、継続的な対話システムなど、より動的で実用的なAI体験が実現されます。これにより、教育、エンターテインメント、ヘルスケアなど、様々な分野での活用可能性が広がります。

創作・生成能力の統合

マルチモーダルAIの進化により、テキスト、画像、音声、動画を組み合わせた総合的な創作活動が可能になります。例えば、小説の文章から自動的に挿絵を生成し、さらにナレーション音声や背景音楽を付加して、総合的なマルチメディアコンテンツを創出できるようになります。

この技術は、コンテンツ制作業界に革命をもたらし、個人クリエイターでも高品質なマルチメディアコンテンツを効率的に制作できるようになります。また、言語の壁を越えたグローバルなコンテンツ展開も容易になります。

実世界との相互作用

ロボティクスとの統合により、マルチモーダルAIが物理世界と直接相互作用できるようになります。視覚、聴覚、触覚などのセンサー情報を統合的に処理し、複雑な環境での自律的な行動が可能になります。これにより、家庭用ロボット、自動運転車、産業用ロボットなどの実用性が飛躍的に向上します。

9-3. 社会インフラとしてのLLM活用

LLMは個別のアプリケーションを超えて、社会基盤としての役割を担うようになると予想されます。この変化により、社会システム全体の効率性と利便性が大幅に向上する可能性があります。

公共サービスのAI化

行政サービスにおけるLLM活用により、市民の利便性向上と行政効率の改善が期待されます。24時間対応の行政相談窓口、多言語での行政情報提供、複雑な手続きの自動化支援などが実現されます。また、政策立案支援、法令文書の自動翻訳、議事録の自動作成など、行政業務の効率化にも活用されます。

さらに、災害時の情報収集・配信、緊急時の多言語対応、避難指示の自動生成など、危機管理分野での活用も重要な用途となります。これにより、より迅速で的確な災害対応が可能になります。

教育システムの変革

教育分野では、個別最適化された学習支援により、従来の一律教育から個人の能力や興味に応じたカスタマイズ教育への転換が進みます。LLMが各学習者の理解度や学習スタイルを分析し、最適な教材や指導方法を提案することで、学習効果の最大化が図られます。

また、言語の壁を越えた国際的な教育機会の提供、専門分野の最新知識の即座な教材化、学習者同士の協働学習支援など、教育の質と機会の向上が実現されます。

医療・ヘルスケアのインフラ化

医療分野では、LLMが医療情報の統合管理、診断支援、治療方針の提案、患者教育などの幅広い分野で活用されます。膨大な医学文献や症例データを統合的に分析し、医師の診断・治療判断を支援することで、医療の質と効率が向上します。

特に、医師不足が深刻な地域での遠隔医療支援、希少疾患の診断支援、個別化医療の推進などで重要な役割を果たします。また、健康管理アドバイス、予防医学の推進、メンタルヘルスサポートなど、予防・健康増進分野での活用も期待されます。

9-4. 2025年以降の技術予測

2025年以降のLLM技術は、さらなる飛躍的進歩が予想されます。現在の技術課題の解決と新しい能力の獲得により、社会への影響はより深刻で広範囲になると考えられます。

技術性能の予測

パラメータ数は10兆を超える超大規模モデルが登場し、人間を上回る推論能力や創造性を獲得する可能性があります。一方で、効率化技術の進歩により、現在のGPT-4レベルの性能をスマートフォンで実行できるようになることも予想されます。

処理能力の向上により、リアルタイムでの複雑な推論、長期記憶の活用、自律的な学習と改善、複数の専門分野を横断した統合的な問題解決などが可能になります。また、人間の感情や意図をより深く理解し、共感的で適応的な対応ができるようになります。

新しい活用領域

科学研究においては、LLMが仮説生成、実験設計、結果分析、論文執筆などの研究プロセス全体を支援し、科学的発見の加速が期待されます。また、法律分野では、判例分析、契約書作成、法的リスク評価などで専門家レベルの支援が可能になります。

芸術・エンターテインメント分野では、個人の好みに完全に合わせた音楽、小説、映画の自動生成により、パーソナライズされたコンテンツ体験が実現されます。また、バーチャルリアリティと組み合わせることで、没入感の高いインタラクティブな物語体験も可能になります。

社会制度への影響

LLMの高度化により、労働市場の構造的変化が加速します。知識労働の多くがAIで代替可能になる一方で、AI管理、創造的協働、人間関係構築などの新しい職種が生まれます。これに対応して、教育制度、職業訓練制度、社会保障制度の根本的見直しが必要になります。

また、AI生成コンテンツの著作権、AI判断の法的責任、AIバイアスの社会的影響など、新しい法的・倫理的課題への対応も重要になります。国際的な協調による規制枠組みの構築が求められるでしょう。

技術の民主化

LLM技術のオープンソース化と軽量化により、小規模企業や個人でも高度なAI技術を活用できるようになります。これにより、イノベーションの担い手が大企業から中小企業、個人へと拡散し、より多様で創造的なAI活用が生まれる可能性があります。

同時に、AI技術格差の拡大や悪用のリスクも増大するため、適切な教育とガバナンスの仕組み構築が重要になります。AI リテラシーの向上と倫理的利用の促進が、社会全体の課題となるでしょう。

10. まとめ

10-1. ChatGPTと言語モデルの本質的理解

本記事を通じて、ChatGPTと大規模言語モデルの関係性とそれぞれの本質的特徴を理解していただけたことと思います。重要なポイントを改めて整理し、今後の AI活用に向けた基盤知識として確認しましょう。

技術的関係性の再確認

大規模言語モデル(LLM)は、膨大なテキストデータから言語のパターンを学習し、人間のような自然な文章生成を可能にする基盤技術です。ChatGPTは、このLLM技術をベースに、特に対話体験に特化した最適化を施したサービスです。つまり、LLMという「エンジン」を搭載したChatGPTという「完成車」という関係性にあります。

この理解により、他のLLMサービスとの比較や、自社でのLLM活用を検討する際の適切な判断基準を持つことができます。技術の本質を理解することで、マーケティング的な宣伝文句に惑わされることなく、実用性に基づいた選択が可能になります。

実用性と限界の認識

ChatGPTをはじめとするLLMは、文章作成、翻訳、要約、アイデア生成など多くの分野で人間レベルまたはそれを上回る性能を示します。しかし、ハルシネーション、バイアス、専門知識の限界など、重要な課題も存在します。

これらの特性を正しく理解し、適切な用途で活用することで、LLMの恩恵を最大化しつつリスクを最小化できます。万能ツールではなく、特定の特性を持つ強力な支援ツールとして位置づけることが重要です。

継続的学習の重要性

AI技術は急速に進歩しており、数ヶ月単位で新しい機能や改善が提供されています。今回得た知識を基盤として、継続的に最新動向をフォローし、新しい活用方法を模索することが重要です。特に、日本語LLMの発展や規制動向には注意を払う必要があります。

10-2. 今後の活用に向けた実践的アプローチ

ChatGPTと言語モデルの理解を踏まえて、実際のビジネス活用に向けた具体的なアクションプランを提示します。段階的なアプローチにより、効果的で持続可能なAI活用を実現しましょう。

段階的導入戦略

LLMの導入は、小規模な実証実験から始めて段階的に拡大することが推奨されます。第1段階では、リスクの低い補助的業務(文書の下書き作成、アイデアブレインストーミングなど)から開始し、効果と課題を確認します。

第2段階では、実証実験の結果を基に適用範囲を拡大し、より重要な業務への適用を検討します。第3段階では、組織全体での本格運用を開始し、継続的な改善サイクルを確立します。この段階的アプローチにより、リスクを管理しながら効果的な導入が可能になります。

組織能力の構築

LLM活用の成功には、技術導入だけでなく組織能力の構築が不可欠です。まず、AI活用に関する社内ガイドラインを策定し、適切な利用方法と禁止事項を明確にします。次に、従業員向けのトレーニングプログラムを実施し、プロンプトエンジニアリングスキルや AI倫理に関する理解を深めます。

また、AI活用の推進役となるチャンピオンを各部署に配置し、現場での活用促進と課題解決を支援する体制を構築します。継続的な成果測定と改善により、組織全体のAI活用レベルを向上させることができます。

将来への備え

AI技術の急速な進歩に対応するため、柔軟性と適応性を重視した戦略が重要です。特定のツールやサービスに過度に依存することなく、複数の選択肢を維持し、新しい技術の評価・導入プロセスを確立します。

また、AGIやマルチモーダルAIなど、将来的な技術発展を見据えた長期戦略も検討が必要です。現在の投資が将来の技術発展にどのように活用できるかを考慮し、持続可能なAI活用基盤を構築することが重要です。

価値創造への発展

最終的な目標は、LLMを単なる効率化ツールとしてではなく、新しい価値創造の源泉として活用することです。既存業務の改善を超えて、新しいサービスの創出、顧客体験の革新、ビジネスモデルの変革などに LLMを活用する可能性を探索します。

これにより、競合他社との差別化を図り、持続的な競争優位を確立できます。AI技術を戦略的に活用することで、デジタル変革のリーダーとしてのポジションを確立し、将来の成長基盤を構築することが可能になります。

社会的責任の履行

LLM活用において、技術的・経済的効果だけでなく、社会的責任の履行も重要な要素です。AI倫理の遵守、バイアスの排除、透明性の確保、プライバシーの保護など、責任あるAI活用により、社会全体のAI技術発展に貢献します。

これらの取り組みは、企業の社会的信頼性向上にもつながり、長期的なビジネス成功の基盤となります。技術の力と社会的責任を両立させることで、持続可能で価値あるAI活用を実現できるでしょう。

記事のポイント総括

- 包括的理解の提供 – ChatGPTと大規模言語モデルの関係性を基礎から応用まで体系的に解説

- 最新動向の反映 – 2024-2025年の日本語LLM開発状況や技術トレンドを詳細に紹介

- 実践的価値の重視 – プロンプトエンジニアリングやビジネス活用の具体的手法を提供

- 課題と対策の明示 – ハルシネーション、バイアス、著作権など重要な課題への対処法を解説

- 未来志向のアプローチ – AGIやマルチモーダルAIなど将来技術への展望を提示

この記事で得られる価値

本記事は、「chatgpt 言語モデル」について検索するユーザーのニーズに包括的に答える内容となっています。AI初心者から専門家まで、それぞれのレベルに応じた実用的な知識を提供し、実際のビジネス活用に向けた具体的な指針を示しています。

特に、国産LLMの最新動向、プロンプトエンジニアリングの実践テクニック、企業導入のフレームワークなど、他の記事では語られていない独自の価値を提供しています。これらの知識を活用することで、効果的で責任あるAI活用を実現し、競争優位の確立につなげることができるでしょう。

※本記事にはAIが活用されています。編集者が確認・編集し、可能な限り正確で最新の情報を提供するよう努めておりますが、AIの特性上、情報の完全性、正確性、最新性、有用性等について保証するものではありません。本記事の内容に基づいて行動を取る場合は、読者ご自身の責任で行っていただくようお願いいたします。本記事の内容に関するご質問、ご意見、または訂正すべき点がございましたら、お手数ですがお問い合わせいただけますと幸いです。