LLMとは?機械学習との違いを徹底解説

LLM(大規模言語モデル)は自然言語処理に特化した汎用AIで、従来の機械学習とはデータ処理方法・出力形式・適用領域が根本的に異なります。技術選択では、創造性と柔軟性が必要な業務にはLLM、高精度な数値予測には機械学習が適しており、初期投資と運用コストの構造も大きく違うため総合的な評価が重要です。最も効果的なのは両技術を組み合わせたハイブリッドアプローチで、各技術の強みを活かしながら、用途・コスト・組織能力を考慮した戦略的な技術選択が競争優位の鍵となります。

AI技術の急速な発展により、LLM(大規模言語モデル)という言葉を耳にする機会が増えています。ChatGPTやGeminiなどの生成AIの基盤技術として注目を集めるLLMですが、従来の機械学習とは何が違うのでしょうか。

本記事では、LLMと機械学習の本質的な違いから、技術選択の判断基準まで、初心者の方にも分かりやすく解説します。これからAI技術の導入を検討している企業の担当者や、AI分野での学習を始めたい方に、実践的な判断材料をお届けします。

LLM(大規模言語モデル)の基本知識

LLMとは何か – 定義と特徴

LLM(Large Language Model)とは、膨大な量のテキストデータを学習した大規模な人工知能モデルです。日本語では「大規模言語モデル」と呼ばれ、人間のような自然な文章生成や理解を可能にする革新的な技術として注目されています。

LLMの最大の特徴は、数千億から数兆個のパラメータを持つ巨大なニューラルネットワークにあります。これにより、書籍、論文、ニュース記事、ウェブページなど、インターネット上の膨大なテキストデータから言語の構造やパターンを深く学習できます。従来の言語処理技術と比較して、文脈を理解した自然な応答や、複雑な質問への的確な回答が可能となりました。

現在のLLMは、単なる文章生成だけでなく、翻訳、要約、プログラミング、創作活動など多様なタスクを高精度で実行できます。この汎用性の高さが、多くの企業や研究機関でLLMの活用が急速に広がっている理由です。

従来の言語モデルからの進化

従来の言語モデルは、比較的小規模なデータセットと限定的なパラメータ数で構築されていました。そのため、文章生成や翻訳において精度や自然さに課題があり、実用的な活用は限定的でした。

LLMの登場により、この状況は劇的に変化しました。Transformerアーキテクチャの採用により、文脈の理解能力が飛躍的に向上し、より人間らしい応答が可能になりました。特に、自己注意機構(Self-Attention)により、文章内の単語間の関係性を効果的に捉えることができるようになったのです。

また、従来のモデルでは特定のタスクごとに個別の学習が必要でしたが、LLMは事前学習により幅広いタスクに対応できる汎用性を獲得しました。これにより、少ない追加学習で新しいタスクに適応できる「転移学習」の効果も大幅に向上しています。

LLMが注目される背景と市場動向

LLMが急速に注目を集める背景には、ChatGPTの爆発的な普及があります。2022年11月のリリース以降、わずか5日間で100万ユーザーを突破し、AI技術の実用性を世界中に示しました。

企業での導入も加速しており、業務効率化の観点から大きな期待が寄せられています。文書作成、カスタマーサポート、データ分析レポートの自動生成など、従来人間が行っていた知的作業の多くをLLMが支援できるようになりました。

市場規模も急拡大しており、調査会社の予測では、LLM関連市場は2024年の約400億ドルから2030年には2,000億ドルを超える規模に成長すると予想されています。この成長を牽引しているのは、企業のDX推進ニーズと、AI技術の民主化による活用領域の拡大です。

代表的なLLMサービスの紹介

現在、市場には複数の優秀なLLMサービスが提供されています。OpenAI社の「GPT-4」は最も知名度が高く、ChatGPTとして多くのユーザーに利用されています。その高い文章生成能力と対話性能により、ビジネスから教育まで幅広い分野で活用されています。

Google社からは「Gemini」(旧Bard)がリリースされており、検索エンジンとの連携により最新情報へのアクセスが特徴です。また、Anthropic社の「Claude」は安全性と倫理性を重視した設計で、企業での導入が進んでいます。

Meta社の「LLaMA」やオープンソース系のモデルも注目されており、多様な選択肢が提供されています。これらのサービスは、それぞれ異なる特徴と強みを持っており、用途や要件に応じて適切なモデルを選択することが重要です。

機械学習の基礎と種類

機械学習の基本概念

機械学習(Machine Learning)とは、コンピュータがデータから自動的にパターンを学習し、明示的にプログラムされることなく予測や判断を行う技術です。人工知能(AI)の一分野であり、統計学やデータマイニング手法を活用してモデルを構築します。

機械学習の基本的な仕組みは、大量のデータを入力として与え、そこから統計的なパターンや特徴を抽出することです。例えば、手書き数字の認識では、数千枚の手書き数字画像を学習データとして与え、各数字の特徴を学習させます。学習が完了したモデルは、新しい手書き数字画像を見て、それが何の数字かを予測できるようになります。

機械学習の重要な特徴は、データが増えるほど精度が向上することです。また、人間が明示的にルールを記述する必要がないため、複雑なパターンや人間では発見困難な関係性を見つけ出すことができます。この特性により、画像認識、音声認識、自然言語処理など、従来のプログラミングでは困難だった問題の解決が可能になりました。

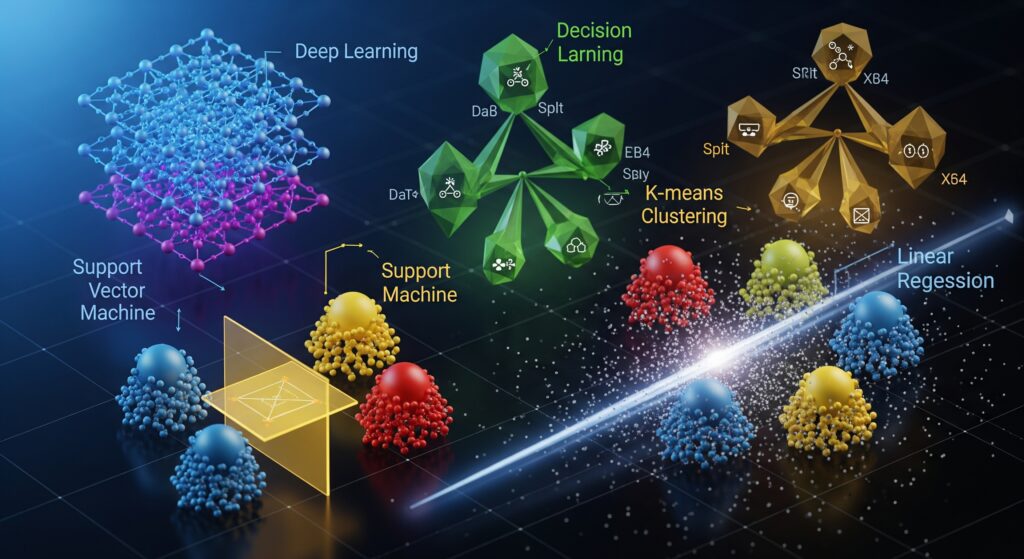

教師あり・教師なし・強化学習の違い

機械学習は学習方法によって大きく3つの種類に分類されます。教師あり学習は、正解データ(ラベル)が付いた訓練データを使用する手法です。入力データと対応する正解のペアを大量に与えることで、新しいデータに対する予測を行えるモデルを構築します。

分類問題(スパムメールの判定など)と回帰問題(株価予測など)が教師あり学習の代表例です。企業では顧客の購買予測、不良品検出、売上予測などの業務で広く活用されています。明確な目標値があるタスクに適しており、精度の評価も比較的容易です。

教師なし学習は、正解データがない状況でデータの構造やパターンを発見する手法です。クラスタリング(顧客セグメンテーション)、次元削減、異常検知などが該当します。強化学習は、環境との相互作用を通じて最適な行動を学習する手法で、ゲームAIやロボット制御で成果を上げています。

機械学習の活用領域と成功事例

機械学習は現在、あらゆる業界で活用されており、その応用範囲は年々拡大しています。金融業界では、信用リスク評価や不正取引検出に機械学習が活用され、従来の統計手法では発見困難だった詐欺パターンの検出が可能になりました。

医療分野では、画像診断支援システムが実用化されており、CTスキャンやMRI画像から病変を自動検出する技術が医師の診断精度向上に貢献しています。放射線科医の診断精度を上回る性能を示す事例も報告されており、医療の質向上と効率化を同時に実現しています。

製造業では、予知保全システムが注目されています。センサーデータから機械の故障を事前に予測し、計画的なメンテナンスを実現することで、突発的な設備停止を大幅に削減できます。また、品質管理においても、製品の微細な欠陥を自動検出するシステムが導入され、品質向上とコスト削減を実現しています。

従来の機械学習手法の特徴

従来の機械学習では、特徴量エンジニアリングが重要な工程でした。これは、生データから機械学習モデルが学習しやすい数値形式の特徴量を人間が設計・抽出する作業です。テキストデータであればTF-IDF、画像データであれば色ヒストグラムやエッジ検出など、ドメイン知識に基づいた特徴量設計が性能を大きく左右していました。

代表的な手法として、線形回帰、ロジスティック回帰、決定木、ランダムフォレスト、サポートベクターマシン(SVM)などがあります。これらの手法は比較的軽量で解釈しやすく、少量のデータでも良好な性能を発揮することが特徴です。

従来手法の強みは、計算コストが低く、結果の解釈が容易な点です。また、ドメイン専門家の知識を活用しやすく、なぜその予測結果になったかを説明できる透明性があります。金融や医療など、説明可能性が重視される分野では、現在でも従来手法が重要な役割を果たしています。

LLMと機械学習の本質的な違い

データ処理アプローチの違い

LLMと従来の機械学習の最も大きな違いは、データ処理のアプローチにあります。従来の機械学習では、人間が手動で特徴量を設計し、データを数値化してモデルに入力する必要がありました。例えば、テキスト分析では単語の出現頻度を計算したり、画像分析では色や形状の特徴を数値化したりする前処理が必要です。

一方、LLMは生のテキストデータを直接処理できます。内部で自動的にトークン化(単語や文字の分割)を行い、文脈を考慮した高次元のベクトル表現を学習します。この表現学習により、単語の意味関係や文章構造を自動的に理解し、人間が設計した特徴量を上回る表現力を獲得しています。

データ量の要件も大きく異なります。従来の機械学習では数百から数万件のデータでも有効なモデルを構築できますが、LLMは数十億から数兆トークンの巨大なデータセットを必要とします。しかし、この大規模データにより、LLMは汎用的な言語理解能力を獲得し、少ない追加データで新しいタスクに適応できる転移学習能力を持っています。

学習方法とアルゴリズムの比較

学習メカニズムにおいて、従来の機械学習はタスク特化型のアプローチを取ります。スパム検出、画像分類、売上予測など、特定の問題に対して最適化されたアルゴリズムとデータセットを用いてモデルを構築します。各タスクごとに異なる手法や特徴量設計が必要となり、専門知識と経験が重要な要素となります。

LLMは事前学習(Pre-training)と微調整(Fine-tuning)の二段階学習を採用しています。まず、膨大なテキストデータで言語の一般的なパターンを学習し、その後、特定のタスクに適応させます。この汎用的な事前学習により、翻訳、要約、質問応答など多様なタスクを単一のモデルで処理できます。

アルゴリズムの違いも顕著です。従来の機械学習では線形回帰、決定木、SVMなど様々な手法から問題に応じて選択しますが、LLMは主にTransformerアーキテクチャに基づいています。Self-Attentionメカニズムにより、文章内の全ての単語間の関係を並列的に処理し、長距離の文脈依存関係を効果的に捉えることができます。

出力形式と精度の特徴

出力形式において、従来の機械学習は数値予測や分類結果を主に出力します。回帰では連続値、分類では確率やクラスラベルを返し、結果は定量的で解釈しやすい形式となります。予測精度も統計的指標(MSE、RMSE、Accuracy、F1スコアなど)で明確に評価できます。

LLMの出力は主に自然言語テキストです。質問に対する回答、文章の要約、翻訳結果など、人間が理解しやすい形式で出力されます。しかし、この自由度の高さは評価の複雑さにもつながります。生成された文章の品質、正確性、適切性を定量的に評価することは困難で、多くの場合、人間による主観的評価に依存します。

精度の特性も異なります。従来の機械学習では、テストデータに対する予測精度が安定しており、性能のばらつきが少ないことが特徴です。一方、LLMは同じ入力に対しても異なる出力を生成する可能性があり、確率的な性質を持ちます。この特性は創造性や多様性の面では利点ですが、一貫性や再現性が重要なタスクでは課題となることもあります。

汎用性vs専門性の観点

従来の機械学習は高い専門性を特徴とします。特定の問題領域に特化して設計されるため、その分野においては非常に高い精度と効率性を発揮します。例えば、製造業の不良品検出システムは、その工程に特化した画像認識モデルにより、人間を上回る検出精度を実現しています。

LLMの最大の強みは汎用性にあります。単一のモデルで文章生成、翻訳、要約、質問応答、プログラミング支援など、多岐にわたるタスクを実行できます。この汎用性により、新しいタスクへの適応が容易で、開発コストと時間を大幅に削減できます。

ただし、この汎用性と専門性にはトレードオフがあります。LLMは多くのタスクをこなせますが、特定分野の専門システムと比較すると精度で劣る場合があります。高精度が要求される医療診断や金融リスク評価などでは、従来の機械学習による専門システムが依然として重要な役割を果たしています。適用場面に応じて、汎用性と専門性のバランスを考慮した技術選択が重要となります。

実装・運用における違い

必要な技術スキルと学習コスト

LLMと従来の機械学習では、習得すべき技術スキルが大きく異なります。従来の機械学習では、統計学の基礎知識、プログラミング(Python、R)、データ前処理、特徴量エンジニアリング、モデル選択と評価などの幅広いスキルが必要です。これらの習得には通常6ヶ月から2年程度の学習期間が必要とされています。

LLMの活用では、プロンプトエンジニアリングが中心的なスキルとなります。適切な指示文を作成し、望ましい出力を得るための技術です。従来の機械学習と比較して、統計学や数学の深い知識は必須ではなく、実用的な活用であれば数週間から数ヶ月で基本的なスキルを習得できます。

ただし、LLMの本格的な開発や微調整を行う場合は、深層学習、Transformerアーキテクチャ、大規模分散学習などの高度な専門知識が必要になります。また、計算資源の管理、モデルの最適化、セキュリティ対策など、インフラ面での専門性も求められます。企業での導入を考える場合、用途に応じて必要なスキルレベルを明確にすることが重要です。

開発期間とリソース要件の比較

開発期間において、従来の機械学習プロジェクトは3ヶ月から1年程度の期間を要することが一般的です。問題定義、データ収集、前処理、モデル開発、評価、運用準備という段階的なプロセスを経る必要があります。特にデータの品質向上と特徴量設計に多くの時間を費やすことになります。

LLMを活用したソリューションでは、既存のAPIサービス(OpenAI API、Google Gemini APIなど)を利用する場合、数日から数週間で基本的なシステムを構築できます。プロンプトの最適化と統合作業が主な作業となり、大幅な開発期間短縮が可能です。

リソース要件も大きく異なります。従来の機械学習では、データサイエンティスト、エンジニア、ドメイン専門家などの専門人材が必要ですが、LLMの活用では比較的少数のエンジニアでも実装可能です。ただし、独自のLLMを開発する場合は、大規模な計算資源と専門チームが必要となり、投資規模は数億円から数十億円に達する場合もあります。

インフラ・ハードウェア要件

インフラ要件において、従来の機械学習は比較的軽量なシステムで運用可能です。CPUベースのサーバーでも多くのタスクを処理でき、メモリ要件も数GBから数十GB程度で済むことが多いです。クラウドサービスの小規模インスタンスでも十分な性能を発揮できます。

LLMの運用では、特に自社でモデルをホスティングする場合、高性能なGPUが必須となります。最新のLLMを動作させるには、NVIDIA A100やH100などの高性能GPUを複数台搭載したサーバーが必要で、初期投資額は数百万円から数千万円に達します。また、大容量メモリ(512GB以上)と高速ストレージも必要です。

一方、LLMのAPIサービスを利用する場合、自社でのハードウェア投資は不要となります。利用量に応じた従量課金制で、初期投資を抑制しながらスケーラブルなシステムを構築できます。中小企業や実証実験段階では、APIサービスの活用が現実的な選択肢となります。ネットワーク帯域と可用性の確保が主な技術要件となります。

メンテナンスと改善方法の違い

従来の機械学習では、継続的なモデル改善が重要な運用要素となります。新しいデータの追加、特徴量の見直し、ハイパーパラメータの調整、モデルの再学習などを定期的に実施します。データドリフト(データ分布の変化)への対応も必要で、モデルの性能監視と適応的な更新が求められます。

LLMのメンテナンスは、主にプロンプトの最適化とファインチューニングに焦点が当たります。ユーザーフィードバックに基づいてプロンプトを改善し、出力品質を向上させます。APIサービスを利用している場合、プロバイダー側でのモデル更新により自動的に性能向上の恩恵を受けられることも多いです。

コスト管理の観点でも違いがあります。従来の機械学習は初期開発後の運用コストが比較的安定していますが、LLMのAPIサービスは利用量に比例してコストが増加します。そのため、使用量の監視とコスト最適化が継続的な運用課題となります。また、プロンプトの効率化により、同じ結果をより少ないトークン数で実現する最適化も重要な運用改善ポイントです。

用途別の選択指針

LLMが最適な用途とその理由

自然言語処理が中心となるタスクでは、LLMが圧倒的な優位性を発揮します。カスタマーサポート、コンテンツ作成、文書要約、多言語翻訳などの業務では、従来の機械学習では実現困難だった高品質な結果を得られます。特に、文脈を理解した応答や創造的な文章生成が必要な場面では、LLMの選択が必須となります。

プロトタイプ開発や概念実証(PoC)段階では、LLMの活用により開発期間を大幅に短縮できます。複雑なルールベースシステムや専用AIモデルの開発に数ヶ月を要するタスクでも、適切なプロンプト設計により数日から数週間で実用的なシステムを構築可能です。

多様なタスクを統合的に処理する必要がある業務でも、LLMが有効です。例えば、メール対応、資料作成、データ分析レポート生成を一つのシステムで処理したい場合、従来なら複数の専用システムが必要でしたが、LLMなら単一のモデルで対応できます。これにより、システム統合の複雑さとコストを大幅に削減できます。

従来の機械学習が有効なケース

高精度な数値予測が要求される分野では、従来の機械学習が依然として重要な役割を果たしています。株価予測、需要予測、リスク評価などの金融・経営分析では、統計的手法による精密な数値計算が必要です。LLMは確率的なテキスト生成に特化しているため、厳密な数値計算には向いていません。

リアルタイム処理が必要なシステムでは、従来の機械学習の方が適しています。製造ラインの品質管理、ネットワーク侵入検知、自動車の衝突回避システムなど、ミリ秒単位の応答速度が求められる用途では、軽量な従来モデルが有効です。LLMは処理時間が長く、リアルタイム性能では劣ります。

説明可能性が重要な業務分野でも、従来の機械学習が選択されます。医療診断支援、融資審査、保険査定などでは、なぜその判断に至ったかの根拠説明が法的・倫理的に要求されます。決定木やロジスティック回帰などの従来手法は、判断プロセスが透明で説明しやすく、規制の厳しい業界では不可欠です。

組み合わせて活用する方法

最も効果的なアプローチは、両技術の組み合わせによる活用です。例えば、顧客データ分析では従来の機械学習で購買予測や顧客セグメンテーションを行い、その結果をLLMに渡してパーソナライズされたマーケティング文章を自動生成するシステムが構築できます。

データ前処理や特徴量抽出に従来の機械学習を使用し、最終的な出力生成や解釈にLLMを活用する手法も有効です。大量の数値データから重要なパターンを抽出し、その結果をLLMが自然言語で要約・報告することで、データサイエンティスト以外でも理解しやすいレポートを自動生成できます。

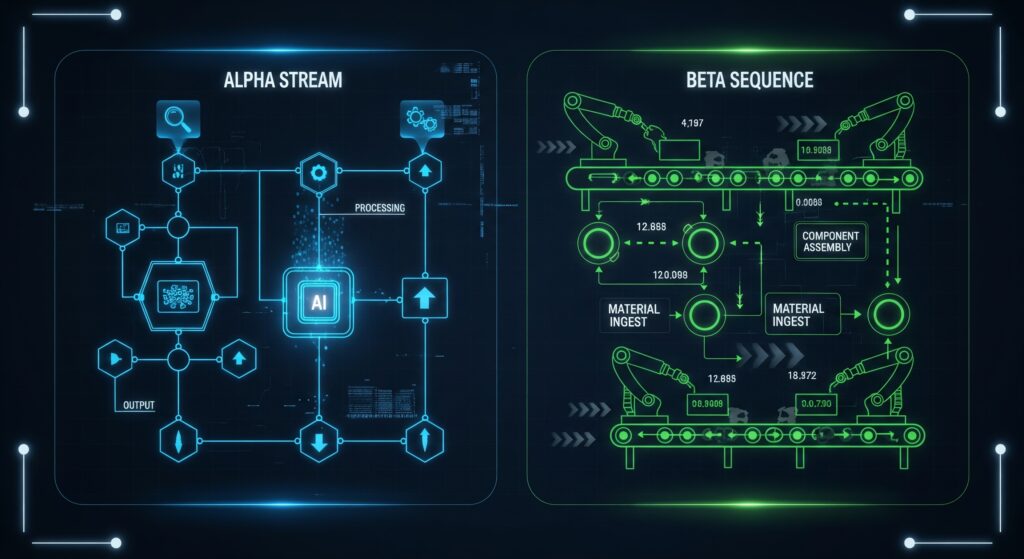

ハイブリッドアーキテクチャでは、タスクの性質に応じて最適な技術を選択的に使用します。構造化データの分析は従来の機械学習、テキスト処理はLLM、全体の統合と出力はAPIオーケストレーションで実現します。この approach により、各技術の強みを最大限に活用できます。

技術選択の判断基準

技術選択では、まず要求される精度レベルを明確にする必要があります。99%以上の高精度が必要な安全性に関わるシステムでは従来の機械学習を、90%程度の精度で十分な業務効率化用途ではLLMを選択することが一般的です。

開発期間と予算も重要な判断要素です。短期間での実装が必要で、初期予算が限られている場合はLLMのAPIサービス活用が適しています。一方、長期的な運用コスト削減と独自性を重視する場合は、従来の機械学習による専用システム開発が有効です。

データの種類と可用性も考慮すべき要因です。大量のラベル付きデータが利用可能な場合は従来の機械学習が有効ですが、少量のデータしかない場合やラベル付けが困難な場合は、事前学習済みのLLMを活用する方が現実的です。また、機密性の高いデータを扱う場合は、オンプレミス運用可能な従来の機械学習が選択されることが多いです。

コストと効果の比較分析

初期投資と運用コストの違い

従来の機械学習プロジェクトでは、初期投資として人件費が最大の要素となります。データサイエンティスト(年収800万円~1,500万円)、機械学習エンジニア(年収700万円~1,200万円)、ドメイン専門家の確保に加え、3ヶ月から1年の開発期間を考慮すると、初期投資は500万円から3,000万円程度が一般的です。

LLMを活用したシステムでは、APIサービス利用の場合、初期投資を大幅に抑制できます。OpenAI APIの場合、1,000トークンあたり0.002ドル程度からスタートでき、プロトタイプ開発なら月額数万円から始められます。開発チームも従来より小規模で済み、初期投資は50万円から500万円程度に抑えることが可能です。

ただし、運用コストの構造は大きく異なります。従来の機械学習では、システム稼働後の変動コストは比較的少なく、主にサーバー維持費とメンテナンス人件費が中心となります。一方、LLMのAPIサービスは利用量に応じた従量課金制のため、システムが成功して利用量が増加すると、運用コストも比例して増加します。月間100万リクエストを処理する場合、月額数十万円から数百万円のコストが発生することもあります。

ROI実現までの期間

従来の機械学習プロジェクトでは、ROI実現まで通常12ヶ月から24ヶ月を要します。開発期間、運用開始後の調整期間、効果測定期間を含めると、投資回収には相当な時間が必要です。特に、精度向上のための継続的な改善や、ビジネスプロセスへの定着に時間を要することが多いです。

LLMを活用したソリューションでは、ROI実現期間を大幅に短縮できる可能性があります。APIサービスを利用した場合、開発期間が短く、初期投資も少ないため、3ヶ月から9ヶ月でROIを実現する事例が報告されています。特に、業務効率化や人件費削減効果が明確な用途では、早期の投資回収が期待できます。

ただし、LLMの効果測定は従来の機械学習より複雑です。顧客満足度の向上、クリエイティブな業務の品質向上など、定量化が困難な効果が多く含まれるためです。ROI計算においては、直接的なコスト削減だけでなく、間接的な効果も考慮した総合的な評価が必要となります。

リスク要因と対策方法

従来の機械学習では、技術リスクとして、データ品質の問題、モデル性能の不足、運用環境での性能劣化などがあります。これらのリスクに対しては、十分な検証期間の確保、段階的な運用開始、継続的な監視体制の構築などの対策が有効です。

LLMにおける主要なリスクは、出力の不確実性とコントロールの困難さです。意図しない内容の生成、機密情報の漏洩、偏見のある出力などのリスクがあります。これらに対しては、プロンプトの厳密な設計、出力内容の自動チェック機能、人間による最終確認プロセスの導入などが必要です。

両技術に共通するリスクとして、技術の陳腐化があります。AI分野の急速な発展により、投資したシステムが短期間で時代遅れになる可能性があります。この対策として、アーキテクチャの柔軟性確保、段階的な投資計画、技術トレンドの継続的な監視が重要です。また、ベンダーロックインを避けるため、複数の技術選択肢を維持することも推奨されます。

成功事例から見る効果測定

大手金融機関での従来機械学習導入事例では、不正検知システムにより年間数億円の損失を防止し、投資額の10倍以上のROIを実現しました。効果測定指標として、検知率の向上(85%→95%)、誤検知率の低下(5%→2%)、調査工数の削減(月間500時間→200時間)などの定量的な成果が報告されています。

LLM活用の成功事例として、大手ECサイトでのカスタマーサポート自動化があります。チャットボットの応答品質向上により、顧客満足度が20%向上し、サポート担当者の工数を40%削減できました。初期投資300万円に対し、年間人件費削減効果2,000万円を実現し、ROI期間は約2ヶ月でした。

効果測定においては、定量的指標(コスト削減、処理時間短縮、精度向上)と定性的指標(顧客満足度、従業員満足度、ブランド価値向上)の両方を追跡することが重要です。特にLLMの場合、創造性や柔軟性の向上など、数値化困難な効果も大きいため、多角的な評価手法の確立が成功の鍵となります。

学習リソースと始め方

LLM活用の学習パス

LLM活用の学習は、実践的なアプローチから始めることを推奨します。まず、ChatGPTやGeminiなどの既存サービスを使用して、プロンプトエンジニアリングの基礎を習得しましょう。効果的なプロンプトの書き方、出力品質の向上技術、安全性の確保方法などを実際に試しながら学習できます。

次の段階では、APIの活用方法を学習します。OpenAI API、Google Gemini API、Anthropic Claude APIなどの公式ドキュメントを参考に、簡単なアプリケーションの開発を経験します。Python、JavaScript、Node.jsなどの基本的なプログラミングスキルがあれば、数週間で実用的なシステムを構築できるようになります。

高度な活用を目指す場合は、ファインチューニング、RAG(Retrieval-Augmented Generation)、エージェント開発などの技術を学習します。これらの技術習得には、深層学習の基礎知識、ベクトル検索、自然言語処理の理論などの学習が必要で、6ヶ月から1年程度の学習期間を要します。

機械学習学習の推奨ルート

従来の機械学習学習では、数学的基礎から始めることが重要です。線形代数、統計学、確率論の基本概念を理解した後、Python、R、SQLなどのプログラミングスキルを習得します。この基礎学習には通常3ヶ月から6ヶ月を要します。

実践的なスキル習得では、scikit-learn、pandas、NumPyなどのライブラリを使用したデータ分析から始めます。Kaggleなどのプラットフォームで実際のデータセットを使用した競技に参加することで、実務に近い経験を積むことができます。また、coursera、Udacity、edXなどのオンライン講座も体系的な学習に有効です。

専門性を高めるためには、特定分野(コンピュータビジョン、自然言語処理、時系列分析など)への特化学習が必要です。深層学習を学ぶ場合は、TensorFlow、PyTorchなどのフレームワークの習得が必要で、この段階まで到達するには総合的に1年から2年の学習期間が必要となります。

実践的なツールと環境構築

LLM活用では、クラウドベースの開発環境が推奨されます。Google Colab、Jupyter Notebook、Replit などの環境では、複雑な環境構築なしに即座に開発を開始できます。また、LangChain、LlamaIndex、Streamlitなどのライブラリを活用することで、効率的なLLMアプリケーション開発が可能です。

機械学習の環境構築では、Anaconda、Docker、Kubernetesなどのツールが重要になります。ローカル開発環境では、Python仮想環境の管理、GPU設定、各種ライブラリの依存関係管理などの技術的課題があります。AWS SageMaker、Google AI Platform、Azure Machine Learningなどのクラウドサービスの活用も選択肢となります。

両技術共通で重要なのは、バージョン管理(Git)、実験管理(MLflow、Weights & Biases)、継続的インテグレーション(CI/CD)などの開発プラクティスです。これらのツールとプロセスの習得により、再現可能で保守性の高いシステム開発が可能になります。

コミュニティとサポート資源

LLM分野では、活発なオンラインコミュニティが形成されています。Reddit(r/MachineLearning、r/OpenAI)、Discord、Slack、Twitter(X)などで最新情報の共有や技術討論が行われています。また、Hugging Face、GitHub、ArXivなどのプラットフォームでは、最新の研究成果やコード実装が公開されています。

日本語コミュニティでは、Machine Learning Tokyo、AI人材育成コミュニティ、技術ブログ(Qiita、Zenn)などが情報源として有用です。定期的な勉強会、ハッカソン、カンファレンス(NeurIPS、ICML、国内AI学会)への参加により、最新トレンドのキャッチアップと人的ネットワークの構築が可能です。

企業での導入支援としては、AWS、Google Cloud、Microsoft Azureなどのクラウドプロバイダーが技術サポートとトレーニングプログラムを提供しています。また、専門コンサルティング会社、システムインテグレーター、技術ベンダーからの支援を受けることで、リスクを抑制した導入が可能になります。学習コストと時間を考慮し、内製と外部支援のバランスを適切に設計することが成功の鍵となります。

まとめ

技術選択のチェックポイント

LLMと機械学習の技術選択において、最も重要なのは目的の明確化です。自然言語処理が中心で、創造性や柔軟性が重要な用途ではLLMを選択し、数値予測や高精度が要求される分析業務では従来の機械学習を選択することが基本原則となります。

コストと期間の制約も重要な判断要素です。短期間での実装と初期投資の抑制を重視する場合はLLMのAPIサービス活用が適しており、長期的な運用コスト削減と独自性を重視する場合は従来の機械学習による専用システム開発が有効です。利用規模の予測も含めて、総合的なコスト評価を行うことが重要です。

技術的リソースと組織能力の評価も必須です。統計学とプログラミングの専門人材が豊富な組織では従来の機械学習が、迅速な実装と運用を重視する組織ではLLMが適しています。また、両技術の組み合わせによるハイブリッドアプローチも検討し、各技術の強みを最大限に活用できる設計を目指すべきです。

将来性と発展の方向性

LLM技術は急速な進歩を続けており、マルチモーダル対応、推論能力の向上、効率性の改善などが進んでいます。GPT-4からGPT-5への進化、GoogleのGeminiシリーズの発展、オープンソースモデルの高性能化など、技術革新のペースは加速しています。

従来の機械学習も、LLMとの融合により新たな発展を見せています。LLMで生成されたデータを機械学習モデルの学習に活用する手法、機械学習の結果をLLMで解釈・説明する仕組み、両技術を組み合わせたハイブリッドシステムなど、相互補完的な活用が主流になりつつあります。

今後5年間で、AI技術の民主化がさらに進み、専門知識がなくても高度なAIシステムを構築できるローコード・ノーコードツールが普及すると予想されます。同時に、AIの安全性、倫理性、説明可能性に対する要求も高まり、技術選択においてこれらの要素の重要性が増していくでしょう。

企業においては、AI技術を戦略的に活用できる組織が競争優位を獲得する時代が到来しています。LLMと機械学習の特性を理解し、適切な技術選択と組み合わせにより、業務効率化、新サービス創出、顧客体験向上を実現することが、持続的な成長の鍵となります。技術の進歩を継続的に監視し、組織の AI 活用能力を段階的に向上させていくことが、これからのビジネス成功に不可欠な要素といえるでしょう。

※本記事にはAIが活用されています。編集者が確認・編集し、可能な限り正確で最新の情報を提供するよう努めておりますが、AIの特性上、情報の完全性、正確性、最新性、有用性等について保証するものではありません。本記事の内容に基づいて行動を取る場合は、読者ご自身の責任で行っていただくようお願いいたします。本記事の内容に関するご質問、ご意見、または訂正すべき点がございましたら、お手数ですがお問い合わせいただけますと幸いです。